工業技術研究院 資訊與通訊研究所 曾蕙如 陳世哲 曾恕康 吳依玲

黎明工程顧問股份有限公司 李坤哲副總經理 黃志杰主任

前言

公共建設的安全一直是國土規劃中的重要環節。交通部運輸研究所網站的資料顯示,全國共有23,070座行車橋梁,其中根據登記資料[1],已有54.45%的橋梁超過20年,23.63%的橋梁缺乏橋齡紀錄。若將這些數據合併,則約有78%的橋梁需要定期進行檢測以確保其安全。因此,橋梁維護成為各縣市政府的重點工程之一。為提升橋面劣化檢測的效率並減少人力需求,我們採用 You Only Look Once(YOLO)架構,特別是 YOLOv8 版本,來進行橋面劣化的檢測工作。透過安裝固定角度的相機在檢測車輛上,錄製橋梁影像畫面,並將這些影像投入 YOLOv8 模型中自動識別橋梁的劣化項目。透過預先收集24,454張照片進行模型的預訓練,並用實際場域的7,978張照片對模型進行微調(Fine-tune)。實驗結果呈現,該模型能夠識別多樣化橋面劣化類別。在時速40至50公里的實際車輛測試中,所錄製影像能被模型準確識別。本研究建立一套完整的硬體與軟體檢測環境,將車輛錄像檢測作為替代人工檢測的工具,顯著提高橋面劣化檢測的效率,為未來橋梁維護工程提供更高品質的自動檢測工具。

精彩內容

1. 橋面劣化檢測簡介

2. 橋面劣化檢測設計

3. 橋面劣化檢測應用案例 |

橋面劣化檢測簡介

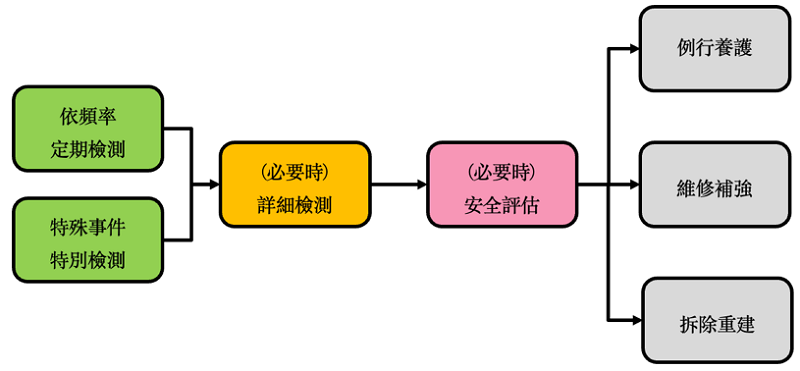

根據公路法第33條規定:“公路設計、施工、養護及交通工程應遵循以人為本的理念,並將保障用路人安全作為原則。其技術規範由交通部制定。” 橋梁的檢測與補強應遵循相關流程進行,如圖1所示。「公路橋梁檢測及補強規範」規定定期檢測以直接目視或間接目視檢測為主,檢測人員於橋面檢測時目前以徒步直接目視進行,惟近年高速公路及省道快速道路施工事故頻傳。據交通部高公局統計,2021年至2022年國道施工車輛或緩撞車遭撞事故已造成5死96傷,2023年截至10月已發生102件,平均每3天就有1起事故發生。

圖1 橋梁檢測與維護流程

為提升橋面劣化檢測的效率並減少人力需求,我們採用 You Only Look Once(YOLO)架構,廣泛應用於缺陷檢測、醫學影像識別、姿態識別等多種電腦視覺任務。YOLO 演算法是一種一階段(One-stage)辨識架構,相比兩階段(Two-stage)辨識模型,如 Faster R-CNN[2],YOLO 在即時偵測性能上更為優越。

自 YOLOv4 [3] 於2020年由王建堯博士等人提出後,其辨識準確度和即時運算能力均有顯著提升,在 COCO 數據集競賽中獲得佳績。同年推出的 YOLOv5 [4],採用 EfficientNet 架構並在網絡層中加入注意力機制,提升模型的識別能力。2022年提出的 YOLOv6 [5] 則專注於降低記憶體佔用,以提升系統運行效率,達到更佳的邊緣檢測效能。 YOLOv7 [6] 與 YOLOv4 為相同作者提出,不同之處在於 YOLOv7 採用稱為擴展高效層聚合網路(E-ELAN)的結構,再度在 COCO 數據集分類競賽中獲得第一名的佳績。目前最新的版本是 YOLOv8 [7],與 YOLOv5 出自同一作者之手,YOLOv8 引入創新設計以提高模型的精準度和運算速度。本研究中採用即為此版本。表1展示 YOLO 模型的發展歷程。

表1 YOLO 模型架構演化表

橋面劣化檢測設計

本章節首先介紹檢測車相機硬體設置及檢測執行方式,並說明劣化檢測資料收集、模型建構,以及實驗環境。

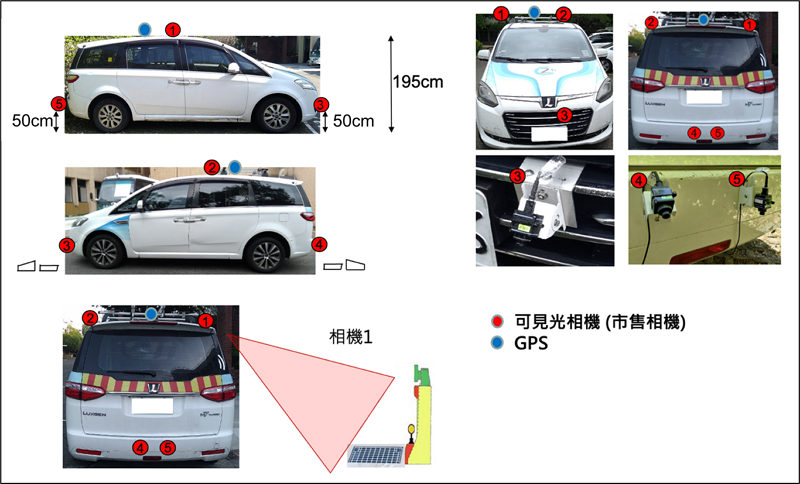

本研究實際架設一台檢測車輛,以模擬未來實際應用的場景。該檢測車輛同時負責收集台74線快速公路的訓練樣本和進行現場測試。檢測任務是在時速40至50公里行駛速度下完成,檢測車輛配置五顆相機鏡頭,每個的視野角度為120度(FOV120)。相機安裝於車頭前方、車頂左右兩側、車尾垂直向下,以及車尾仰角30度的位置。車頂亦配備 GPS 定位系統。相機的配置高度與位置見圖2。右側相機專為觀察護欄及接近的地面狀況,以便檢測研究中關注的橋面劣化項目,圖3展示五個相機的拍攝畫面,每個相機的配置與目的如下:

- 相機1、2(FOV 120):偵測橋護欄、排水設施(距離0.5M~5M)。

- 相機3 (FOV 120):偵測伸縮縫高低差,偵測伸縮縫前高後低。

- 相機4 (FOV 120):偵測伸縮縫高低差,偵測伸縮縫前低後高。

- 相機5 (FOV 120):偵測伸縮縫間隙異常,相機垂直照地面。

- GPS:記錄座標。

圖2 實驗測試車輛相機配置

圖3 測量車輛五顆相機實景,由左上至右下分別為2號、1號、3號、5號、4號相機

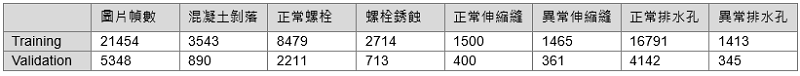

資料收集分為兩階段進行。首先在北新橋、福和橋、永福橋、秀朗橋、華中橋、華新橋、新北環快、台北環快、大直橋、新北橋、台北橋、堤頂大道收集相片以進行模型的預訓練;然後,使用台74線快速公路的相片對模型進行微調(fine-tune)。預訓練樣本的分類數據見表2,而台74線微調相片的各類別樣本數據見表3。

表2 預訓練資料樣本

表3 微調資料樣本

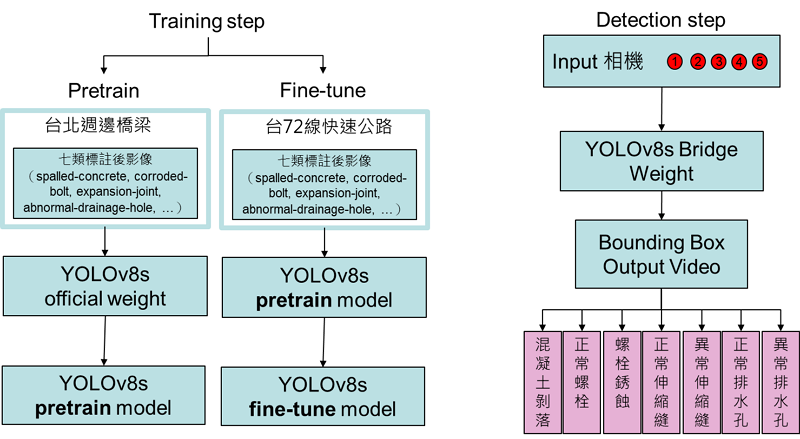

依循圖4流程。在訓練階段,首先從 YOLOv8 載入官方的預訓練權重,隨後逐步調整模型,使其適應台74線的場域資料,進而建立能夠識別劣化類別的 YOLOv8 模型。在偵測階段,將從五個不同角度拍攝的影片投入經過微調的模型中,根據權重辨識影像並繪製物件框,標示物件類別與位置。

圖4 模型訓練流程圖

本研究實驗環境使用 Windows 10 系統,配備 RTX 4070 Ti 12GB 顯卡,為符合辨識效率與準確率(precision)採用 YOLOv8m 模型進行任務,利用 Labelme 軟體進行真實資料(Ground True)標註。

橋面劣化檢測應用案例

本章節將分別介紹實驗中的定性分析與定量分析。首先我們將詳述各類別的平均準確率(mAP),接著呈現各劣化類別辨識的視覺結果,最後將對針對實驗結果進行深入討論。

經過微調後,模型在八個類別上的辨識結果如表4所示。研究中所使用的台72線資料集在部分類別上的資料量相對不均衡,透過重複調整參數和利用預訓練樣本進行重複訓練,實驗結果顯示每一類別的平均準確率仍保有良好水準。

表4 模型辨識準確度

根據上述所訓練的模型,下列將說明檢測結果,並逐一展示這些定性的實驗結果。

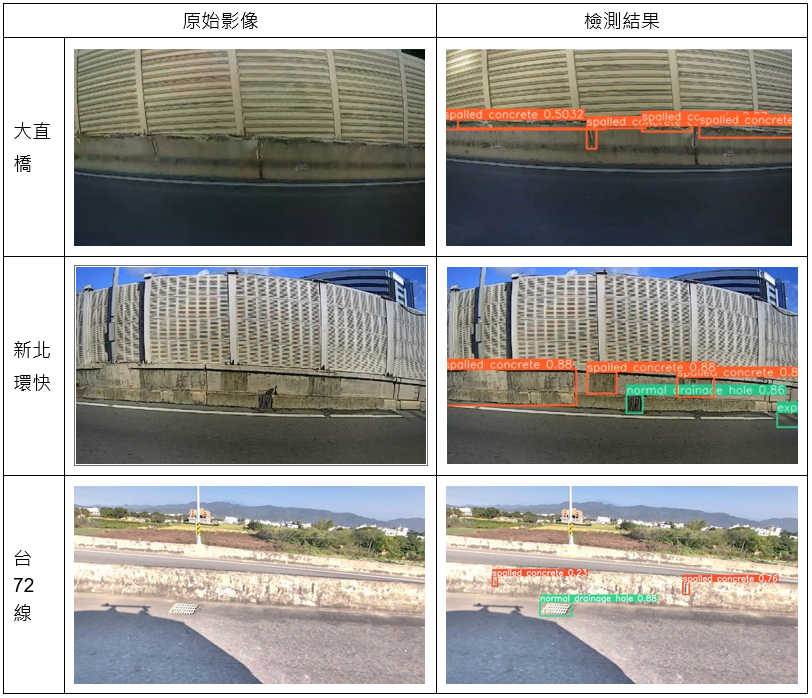

混凝土剝落會導致不規則大小的物體出現,因此辨識結果中物件框的大小各異。儘管如此,模型仍能正確辨識出護欄混凝土剝落的位置,綠框表示檢測結果正常,而橘框表示檢測結果異常,如圖5所示。

圖5 混凝土剝落檢測情形

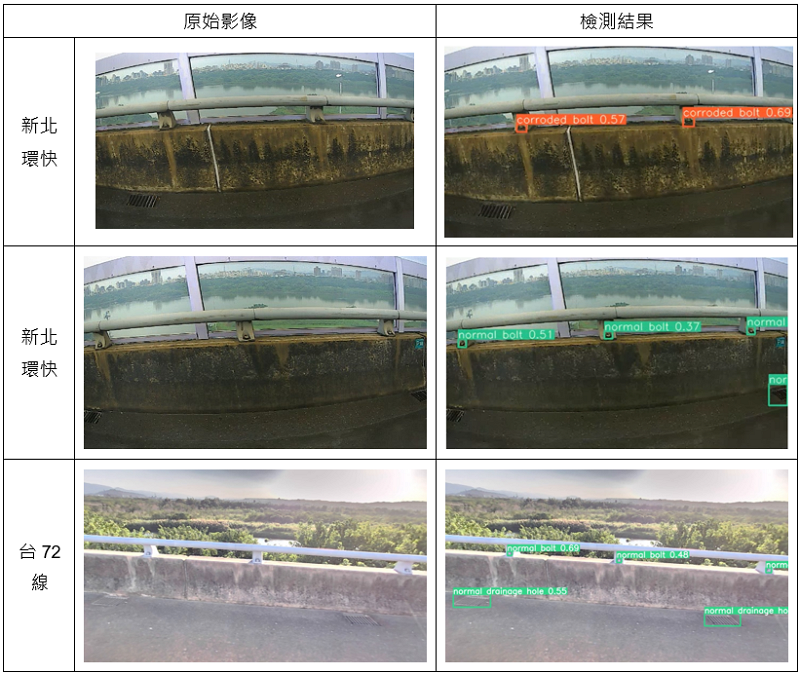

螺栓在影像中屬於較小的物件,即使在人工觀測下也難以準確辨識其位置。在本研究中,我們根據螺栓的外觀顏色來進行標記,若為深褐色則標記為螺栓銹蝕。如圖6所顯示,模型能正確辨識出螺栓的位置和類別。

圖6 螺栓銹蝕檢測情形

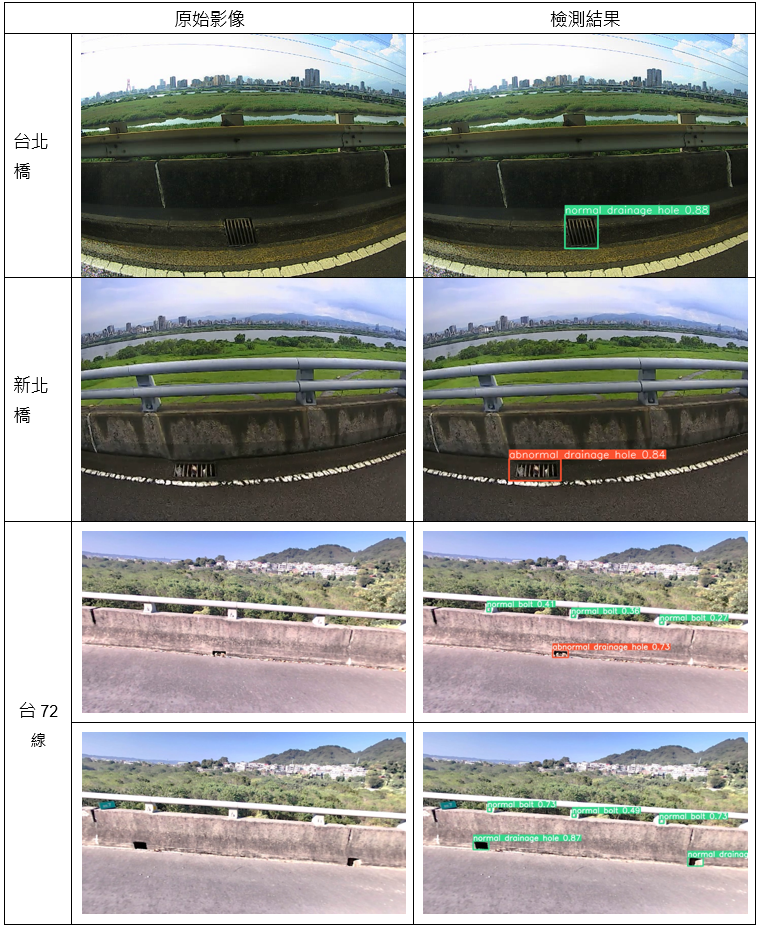

排水設施異常的檢測重點在於判斷排水口是否被異物堵塞,例如花草、泥土、垃圾等。然而,光照造成的影子與色澤差異也可能影響影像辨識的準確性,圖7展示排水設施異常與正常的辨識結果。

圖7 排水設施阻塞檢測情形

伸縮縫的檢測則著重於是否有泥沙、花草堵塞等情況。伸縮縫的類型相當多樣,包括鋸齒型伸縮縫、豎齒型伸縮縫和角鋼伸縮縫等。在本研究收集的資料場域中,鋸齒型伸縮縫出現較多,而豎齒型和角鋼伸縮縫的樣本較少,導致這些類型的辨識準確度較低。在台72線場域中,由於伸縮縫多為鋸齒型,因此辨識結果整體仍然非常良好,如圖8所示。

圖8 伸縮縫阻塞檢測情形

結論

本次研究提出一種結合硬體架設方式與應用預訓練資料建立 YOLOv8 辨識模型的方法,在台72線的橋梁檢測任務中展現良好的性能。本研究除建立實驗檢測車搭載相機與AI運算平台,能在時速40至50公里下清楚捕捉到可辨識的影像資料外,亦提出一種更快速且成本更低的模型建構方法,成功將AI技術應用於實際場景,用物件辨識技術取代人工檢測,顯著提升檢測效率和效果。本研究提供的技術和資料集未來將有助於開發其他可搭載攝影機的檢測載具,為台灣地區的橋梁維護及公共建設安全提供更低風險、有效且高性價比的檢測方案,未來亦可將相關劣化檢測技術擴展應用於其他場域,如軌道或鐵道等應用場域。

參考文獻

[1] 交通部運輸研究所. Available at: https://bss.iot.gov.tw/bss/country/statistics_all/list/ .

[2] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster R-CNN: Towards real-time object detection with re- gion proposal networks. In Advances in Neural Information Processing Systems (NIPS), pages 91–99, 2015.

[3] Alexey Bochkovskiy, Chien-Yao Wang, and Hong- Yuan Mark Liao. YOLO v4: Optimal speed and accuracy of object detection. arXiv preprint arXiv:2004.10934, 2020.

[4] Jocher Glenn. YOLO v5. Available at: https://github.com/ultralytics/yolov5, 2022.

[5] YOLO v6: A Single-Stage Object Detection Framework for Industrial Applications. arXiv preprint arXiv:2209.02976, 2022.

[6] Chien-Yao Wang, Alexey Bochkovskiy, Hong-Yuan Mark Liao. YOLO v7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2023, pp. 7464-7475

[7] Jocher Glenn. YOLO v8. Available at: https://github.com/ultralytics/ultralytics, 2023.