工研院資通所 徐志偉 許博鈞 劉耿豪

目前科技業者與車廠都已投入自駕車系統的發展,特別是專注於通訊、光達感測、定位與操控技術的研發,在自身的產業特色下,兩方發展出現速度和方向不大相同的現象;科技產業在產品研發、量產、上市等要求向來快速,以速度獲取市場商機,而車廠業者則多是百年工業,其產品使用年限長,對安全性的注重度高,從設計到製造,都需要經過較長的時間驗證,這也是車商在自駕車進展較慢的原因。至於發展方向,以美國汽車工程師學會(SAE, Society of Automotive Engineers)制定的自駕車6個等級為例,車廠是由第0層逐步往上推,科技廠商則是先從第5層的完全無人自駕等級,回推思考技術有哪些欠缺,這兩種不同發展方向在時間的推演下,將在一定的技術環節交會。

觀察目前各大廠的自駕車發展,大多是以自小客車為主,在這類應用中,不但車體中的感測器、運算單元、定位單元與操控單元必須具備精準而快速的訊號擷取與反應能力,還須經過長時間的實地測試,以掌握所面對的複雜環境。本文將以自駕車系統中所需採用的通訊與定位技術做為探討的主題。

精彩內容

1. 自駕車系統軟體運作與通訊、定位技術

2. 自駕車系統場域驗證

3. 自駕車安全性三大技術 首推車聯網通訊、定位技術與感測器效能 |

自駕車系統軟體運作與通訊、定位技術

台灣目前由法人(工研院等單位)所制訂自動駕駛感知次系統,其中V2X通訊技術與應用於自駕車軟體架構中於行車安全性與聯網接收號誌狀態資訊的提升上扮演不可或缺的角色。自駕車系統軟體的運作流程概述如下,首先,感測分析硬體(Camera、3D LiDAR、Radar與V2X路側通訊設備)收集車輛周圍的資訊後(如,道路是否有障礙物、道路路形等)先做前置處理與資料對齊,接著透過深度學習影像辨識軟體針對所偵測到的物件與資料做訓練(Training Data),之後將多重感測資料做融合(Data Fusion),然後做即時事件推理(Event Sensing),即區分Event sensing type: Pedestrian crossing road (行人穿越道路)與Intersection Movement Assist (橫向來車)。最後做資料儲存(Data Logging)。

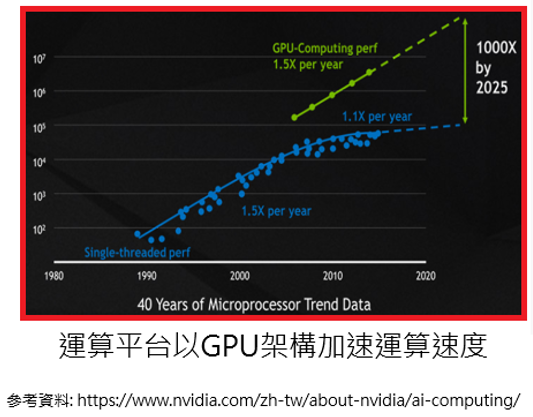

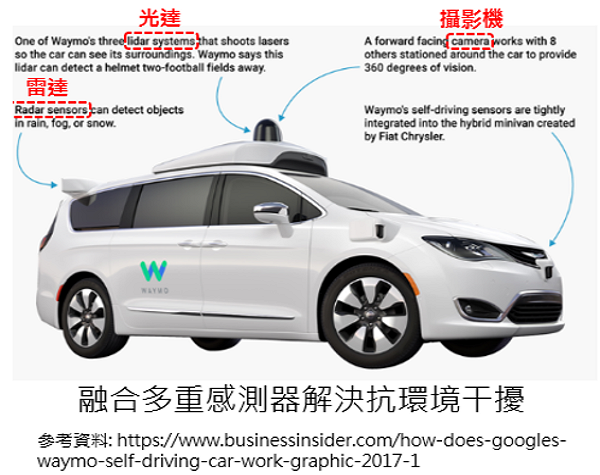

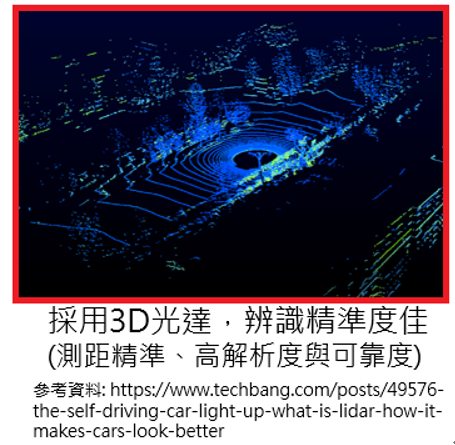

自駕車系統架構中最為關鍵的元件即為前端感測器,感測器為發展自動駕駛技術領域中最為重要的回授單元,近年來隨著先進駕駛輔助系統普遍應用於高階車輛上,並且對於安全、舒適、方便與節能有所改善,使得安裝多個感測器已逐漸成為趨勢,同時成為發展自動駕駛等級SAE Level 5的基礎,透過這些先進的感測器與機器學習軟體演算法的處理,可以讓車輛電控單元完整模擬甚至超越人類在駕駛車輛時所使用的各種感官能力(perception),實現同步即時的全方位環周感測能力,並針對感測結果進行控制決策的判斷,因此感測器的穩定性研究成為目前自動駕駛技術的關鍵要素之ㄧ,其中在運算速度、抗環境干擾能力與辨識精準度上為目前發展的三個重要指標,圖1以Nvidia為例,運算平台採用GPU架構可加速運算,每年以1.5倍的速度成長,預計於2025年將可達到1000倍的運算速度,可滿足與運算多種感測器的融合。圖2以Google新創的自駕車公司Waymo為例,車上配掛光達與攝影機等感測設備,以融合多重感測器解決抗環境干擾。圖3則是顯示目前自駕車採用3D光達技術,以提高物件辨識精準度。

圖1 自駕車運算平台以GPU架構為主流

圖1 自駕車運算平台以GPU架構為主流 圖2 自駕車將融合多種感測器克服環境干擾

圖2 自駕車將融合多種感測器克服環境干擾 圖3 自駕車採用3D光達技術,以提高辨識精準度

圖3 自駕車採用3D光達技術,以提高辨識精準度自駕車通訊技術

自駕車通訊技術,即採用車聯網V2X通訊,使自駕車具有對外連網能力,該技術可區分為兩大類,分別為短距無線通訊DSRC (Dedicated Short Range Communication)與4G C-V2X (Cellular Vehicle-to-Everything)。美國與台灣致力於DSRC系統開發與應用驗證,其實體層採用IEEE 802.11p,目前DSRC系統已進入到成熟期,美國已有多個城市與公路、工研院於六都皆有建置DSRC-based測試場域,以驗證其標準與應用,DSRC目前已有美國電機工程協會 (IEEE, Institute of Electrical and Electronics Engineers)與歐洲電信標準協會 (ETSI, European Telecommunications Standards Institute)兩大標準組織制定多年;反觀4G C-V2X於技術標準的制定,則以中國與歐盟(如,電信商)最為積極參與投入,C-V2X系統以建置電信基地台為主,與4G C-V2X技術標準相關的有3GPP eV2X (enhanced V2X)標準,該標準底層採用LTE-Uu/PC5架構。車聯網V2X通訊發展出多種應用類型,如車對車 (V2V, Vehicle-to-Vehicle)、車對人 (V2P, Vehicle-to-Pedestrian)、車對電信網路 (V2N, Vehicle-to-Network)與車對路 (V2I, Vehicle-to-Infrastructure)。

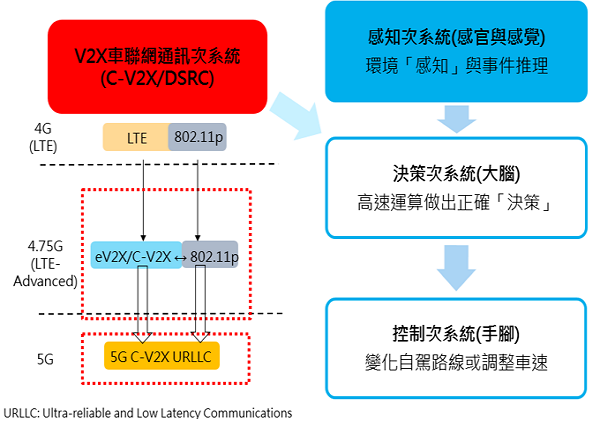

工研院所開發的自駕車系統架構,如圖4所示,其中包含V2X車聯網通訊次系統、感知次系統、決策次系統與控制次系統。V2X車聯網通訊次系統著重提供自駕車對外通訊能力並傳送對外所接收到的訊息給決策次系統,使自駕車具備行車安全防護、接收路側設備所推播前方交通壅塞、速限與異常天候推播與接收路口號誌做優先號誌控制的應用,以上應用將於本期「自駕車結合車聯網之創新應用」文章做介紹。

圖4 自駕車V2X車聯網通訊次系統

圖4 自駕車V2X車聯網通訊次系統自駕車定位技術

自駕車並不像人類一樣有五官知覺,需要透過各種感測器 (如LiDAR、Radar、Camera與超音波Ultrasound等)來探索世界,而定位模組為自駕車了解自己身在世界何處的核心,定位之所以為核心,可以從其需要之應用來看,車輛控制做任何一個決策,首要條件是知道自己位置在哪、相對其他物件位置,才可以做出下層控制決策,這些都需要有定位的資訊。自駕車定位技術首先須為場域建立電子地圖,需先透過繪圖車或相關移動繪圖載具MMS (Mobile Mapping System)進行場域資料的蒐集,包含GNSS (Global Navigation Satellite System)、IMU (Inertial Measurement Unit)、光達點雲特徵等資訊,將這些結果蒐集起來後透過建圖演算法將場域內之電子地圖在離線下建立,其電子地圖資訊包含3D點雲特徵、車道、停止線以及路段編號等資訊,若自駕車需要其他資訊也可以在蒐集或建圖時建立,此建圖需經過精準度測試以及定位測試,以達到自駕車定位的需求。

傳統定位有透過GPS (Global Positioning System)進行定位,但須忍受其1~2公尺的誤差,這部分需要透過其他感測器以及演算法來補償,自駕車需要的定位精準度須達車道內維持需求的公分等級,進而演變到透過RTK (Real Time Kinematic)技術達到公分等級之高精準定位,但單純透過RTK雖然解決了精準度上的問題,但單靠單一感測器仍然有遮蔽造成的定位誤差以及本身更新頻率上的問題,故仍須結合其他感測器來達到修正以及提升速度的需求。近幾年3D光達感測器開始活躍於各種領域,伴隨著自駕車議題的升溫,加上機器人領域早已有透過雷射方式,對其雷射光精準的特性進行建圖與定位[1][2][3][4],相當適合用於公分等級的定位,改善GPS系統精準度穩定的問題,而IMU擁有高更新頻率的特性可用於估測定位狀態,並透過感測器融合演算法UKF (Unscented Kalman Filter)[5]進行感測器資訊融合達到即時高精準度之定位。

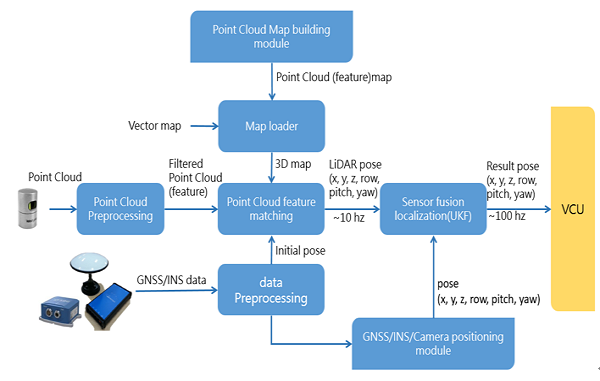

工研院設計與開發UKF定位與感測融合演算法,該演算法整合光達感測器融合自駕車定位模組,如圖5運作流程圖所示,其運作說明如下,在電子地圖模組產出場域地圖資訊,此資訊將與即時點雲資料處理進行光達點雲特徵比對 (Point Cloud feature matching),求得光達定位結果。而GNSS加上INS (Inertial Navigation System)除了提供光達特徵比對之初始以及內部估測結果,另會進行GNSS/INS定位演算法求得定位結果。最後,配合影像以及INS進行位置估測,提供給定位與感測融合演算法所需資訊,最終輸出至VCU (Vehicle Control Unit)車控單元所需之即時定位資訊。

圖5 工研院UKF定位與感測融合演算法運作流程

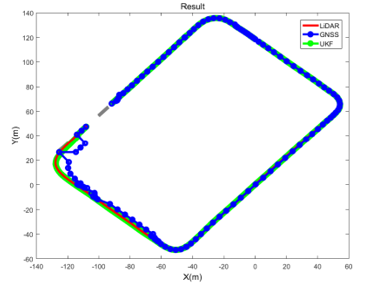

圖5 工研院UKF定位與感測融合演算法運作流程工研院資通所所開發的UKF定位與感測融合演算法經過自駕車平台驗證,於此平台上建立相關環境,並建立電子地圖以及演算法,圖6為其測試結果,包含光達定位、GNSS定位與工研院UKF定位與感測融合演算法之定位結果,從圖6得知繞行工研院院內一圈之定位資訊可以看到GNSS定位結果在某些訊號遮蔽路段會有相當明顯之誤差,此部分誤差是不受自駕車系統所允許的;而在光達定位資訊部分雖然大致上都在10公分以內的定位誤差,但更新頻率約只有10Hz仍無法滿足車輛控制單元需求;而工研院UKF定位與感測融合演算法,不僅包含了光達的高精準定位,也修正了誤差並擁有車控所需的100Hz定位資訊。

圖6 光達LiDAR、GNSS與工研院UKF定位與感測融合演算法定位結果

圖6 光達LiDAR、GNSS與工研院UKF定位與感測融合演算法定位結果自駕車系統場域驗證

在資通所科專S3 (Surrounding Sensing Subsystem)計畫中,已開發出一輛搭載各式感知器的自動駕駛中型巴士,並於2018年12月至2019年1月期間在台中花博水湳經貿場域開放給一般民眾搭乘,其應用體驗於本期「民眾體驗自駕車應用與服務 - 以台中花博為例」文章中做介紹。由於是在實際的道路上做運行,於自動駕駛中巴上搭載了五顆光學雷達,以及九個相機鏡頭,目的是要偵測出所有車輛周圍的物件,以便在危險要發生前做出相對的反應。水湳經貿場域的路線為狹長環狀路線,其中直線路段為雙向雙線道,自動駕駛巴士行駛在靠外側的專用車道,並在頭尾兩端進行迴轉。行駛車速設定在時速15到20公里,迴轉路段則會放慢。

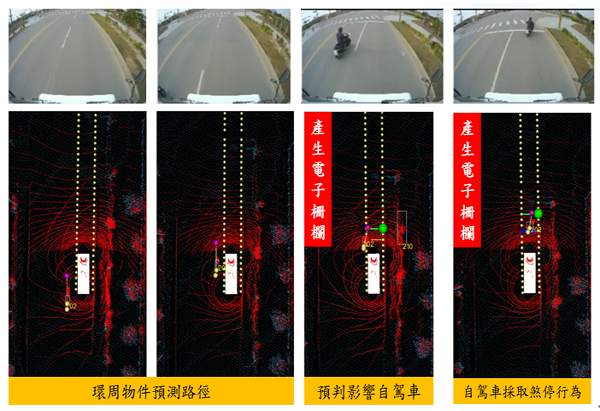

由於是在實際道路上進行驗證,為了確保測試期間自動駕駛車輛有足夠能力防止碰撞發生變成了首要之務。有別於一般自駕車遇到障礙物煞停的設計,於場域測試期間當在行駛路線前方特定距離內偵測到物件時,便踩剎車讓車輛停止,直到前方物件消失或離開才恢復運行,觸發距離則依照當下車速所需要的煞停距離來決定。圖7為實際台中場域運行時所碰到的煞停案例,當左側方的機車切入到自駕中巴行駛的路線上時,自駕系統便採取剎車的反應,讓車輛停下待機車離開後再繼續運行。而為了讓自駕車安全防護的機制更貼近一般人開車的習慣,未來在系統的開發上,會逐步參考更多道路環境中的變因,並強化車輛環周動態物件行為軌跡的預測,讓控制次系統有更靈活的判斷準則。

圖7 台中花博水湳經貿場域自駕車定位與煞停驗證案例

圖7 台中花博水湳經貿場域自駕車定位與煞停驗證案例自駕車安全性三大技術 首推車聯網通訊、定位技術與感測器效能

在V2X車聯網通訊技術(如,DSRC、4G C-V2X)、前端感測元件(如,LiDAR、Radar、Camera)、定位技術與操控技術的發展下,帶動自駕車結合通訊與定位相關的應用與發展。且針對自駕車安全性的應用,需整合包含車載機與路側通訊設備等,以提供即時的通訊能力。此外,有鑒於Google和UBER所發生無人車的事故層出不窮,自駕車開發商不僅需提升感測器的效能,亦開始重視透過V2X車聯網通訊與定位技術提升自駕車的安全,未來自駕車的安全性應用,如結合前方碰撞警示、遇障礙物煞停等相關應用,將成為通訊與定位技術發展的機會所在。

參考文獻

[1] Dissanayake, M. G., Newman, P., Clark, S., Durrant-Whyte, H. F., & Csorba, M. (2001). A solution to the simultaneous localization and map building (SLAM) problem. IEEE Transactions on robotics and automation, 17(3), 229-241.

[2] Levinson, J., Montemerlo, M., & Thrun, S. (2007, June). Map-Based Precision Vehicle Localization in Urban Environments. In Robotics: Science and Systems (Vol. 4, p. 1).

[3] Wan, G., Yang, X., Cai, R., Li, H., Wang, H., & Song, S. (2017). Robust and Precise Vehicle Localization based on Multi-sensor Fusion in Diverse City Scenes. arXiv preprint arXiv:1711.05805.

[4] Kummerle, R., Hahnel, D., Dolgov, D., Thrun, S., & Burgard, W. (2009, May). Autonomous driving in a multi-level parking structure. In Robotics and Automation, 2009. ICRA'09. IEEE International Conference on (pp. 3395-3400). IEEE.

[5] Julier, S. J., & Uhlmann, J. K. (2004). Unscented filtering and nonlinear estimation. Proceedings of the IEEE, 92(3), 401-422.