人的感官系統主要包含視覺、聽覺、觸覺、嗅覺及味覺,藉由外界對這些感官系統的各種刺激讓人有各種不同的體驗,然而虛擬實境(Virtual Reality, VR)主要是以虛擬事物模擬真實世界的事物,透過相同的感官系統讓使用者將虛擬事物誤認為是真實事物,感受真實的程度就是所謂的沉浸感,也因此沉浸感成為現今虛擬實境好壞評估的主要因素之一。

沉浸感的實現

在真實環境中,人的感官系統直接與現實事物互動,但是在虛擬環境中,同樣是利用人的感官系統但卻是與虛擬事物互動,而虛擬事物則是利用電腦產生的事件或物件,視覺部分是以頭戴式顯示器(Head Mounted Display, HMD)將畫面置於眼睛前方,模擬眼睛看到的事物並隔絕外在現實世界對視覺的影響;聽覺的部分是將聲音透過耳機模擬耳朵聽到的虛擬空間聲音,並隔離外在聲音的影響;觸覺的部分則是以穿戴觸覺反饋(haptic feedback)的手套及衣服,透過電氣肌肉刺激(Electrical Muscle Stimulation, EMS)或微型軟性振動模組來模擬觸碰物體的感覺(如圖1在身體、四肢及首長穿戴特殊之觸覺反饋裝置);至於嗅覺在大型遊樂場或電影院可以噴霧方式將氣味散佈於空氣中,但未見個人用之設備或裝置,另一方面因為嗅覺及味覺的體驗多以化學合成為主,無法以電腦方式模擬,故在虛擬實境沉浸感中甚少實現。

![圖1 觸覺反饋裝置(Hardlight VR suit [1])](https://ictjournal.itri.org.tw/files/file_pool/1/0M269517864201794981/Thumbnail%20%2834%29.jpg) 圖1 觸覺反饋裝置(Hardlight VR suit [1])

圖1 觸覺反饋裝置(Hardlight VR suit [1])有研究指出非言語式的訊息傳遞,人會運用其五種感官系統來認知接收訊息,其中視覺約占83%,聽覺約占11%,其他觸覺、嗅覺及味覺約佔6%[2],這也是為何虛擬實境系統多以實現視覺的感受為主,其次為聽覺,再其次為觸覺,至於嗅覺與味覺因為無法以電腦方式模擬,所以甚少有系統能實現嗅覺及味覺,另外觸覺的模擬多僅能模擬碰觸到物體的反應回饋,對物體質感的模擬,如軟或硬、粗糙或光滑則甚為困難,因此本文僅就虛擬實境中視覺與聽覺的沉浸感與挑戰加以詳述。

視覺沉浸感

要有好的視覺沉浸感,必須儘可能模擬在真實環境中人眼所見的影像,包括

- 大視野:人的兩眼合起來有超過180度的視野,但是頭戴顯示器為平面顯示器,且視野不夠大,為模擬人的大視野,需先將顯示影像根據透鏡參數變形,頭戴顯示器再利用透鏡將顯示影像擴大來模擬大視野效果,然而此一效果會壓縮邊緣的一些資訊。

- 高解析:由於人眼的分辨率很高,頭戴顯示器的顯示屏幕離眼睛很近,加上透鏡的放大效果,會觀察到螢幕的個別畫素,若要達到無法分辨個別畫素的程度,估計每隻眼睛的顯示器解析度需達4K以上,畫素處理更要高達8K畫素(兩眼)以上,需要相當強的運算能力。

- 高擬真:由於人眼與大腦接觸真實世界長期的訓練結果,使得人可以輕易分辨目前虛擬實境與真實世界的差異,雖然現今多數電影特效已可合成近似真實世界的影像,不易分辨真假,但是其高擬真程度尚無法即時成像,所以僅能降低畫質呈現,導致在現今的系統中,人在主觀的認知上已經知道畫面呈現的並不真實。

- 低延遲:真實世界中,人眼所觀察的事物會隨著頭部的轉動及身體的移動而即時改變,在虛擬實境系統中,頭部的轉動及身體的移動是仰賴頭戴顯示器上的感測器(如陀螺儀、加速度計等)所獲的的資訊加以解析計算,再根據計算的結果得到近似的觀察方向,由成像加速器根據此一觀察方向進行渲染成像,資料的截取分析與成像計算速度決定了畫面顯示與人體動作是否同步,如果無法同步則會產生感官上與觀察的事物不一致,容易造成暈眩及破壞沉浸感。一個虛擬成像流程的示意圖如圖2所示,中間包含了使用者互動偵測、互動之處理以決定顯示畫面、成像處理即顯示前處理(變形)、及最終顯示幕顯示,整個流程隨使用者互動而循環。

視覺沉浸感需盡可能解決上述問題才能提供好的視覺體驗。

圖2 虛擬實境成像流程示意圖

圖2 虛擬實境成像流程示意圖聽覺沉浸感

在真實環境中,人的耳朵接收的聲音來自四面八方,如圖3所示,包括直接聲響(direct sound)、反射聲響(early reflection)及多重反射餘響(late reverb)。除了聲源發聲外,聲音亦受到距離及環境各種障礙物的反射和遮蔽而有所不同。在虛擬的環境中,為了減少外在真實世界聲音的影響及增加聽覺沉浸感,耳機成了虛擬實境接收聲音的主要裝置。傳統立體聲、5.1聲道、7.1聲道利用固定的喇叭(loudspeaker),模擬聲音從不同的地方來,但是其假設是人是固定在某一特定位置,且頭朝前方接收喇叭傳來的聲音。虛擬實境最大的不同在人的位置和方向是不固定的,畢竟我們在真實世界中接收聲音也是來自各個方向,根據環境不同(例如開闊空間、房間內、隧道內等)和頭部旋轉方向等,都會影響接收的聲音訊號大小,環境與傾聽方向不再是固定的,而是隨著虛擬內容的環境及使用者的互動而需要動態調整,從被動變成主動的接收。舉個例子,假設在客廳看電視,聲音從前方電視喇叭輸出,將頭向右轉會發現左耳會聽到比右耳大聲,另外如果離開客廳到另一個房間,則所聽到的聲音會因為牆壁的反射及阻擋而變小聲或不同。隨著虛擬實境對沉浸感的需求越來越高,近年來Google亦在其VR SDK中提供對空間聲響的支援[3],聽覺沉浸感的也隨著模擬的不同聲響而大幅提高。

圖3 空間聲響的構成

圖3 空間聲響的構成工研院在虛擬實境技術的研發

1990年代(1990~1999):

虛擬實境不是現在才有的,早在二十多年前就有相關的技術,但是因為相關硬體設備昂貴,所以主要仍以研究為主,工研院在虛擬實境技術的研發早在1990年代即開始,那時候頭戴顯示器仍十分笨重,解析度低,動作偵測需仰賴特殊裝置,但是當時PC越來越普及,效能也越來越好,為加速應用程式的開發,微軟(Microsoft)開始制定相關的繪圖與音效標準,繪圖與音效的硬體開始蓬勃發展。

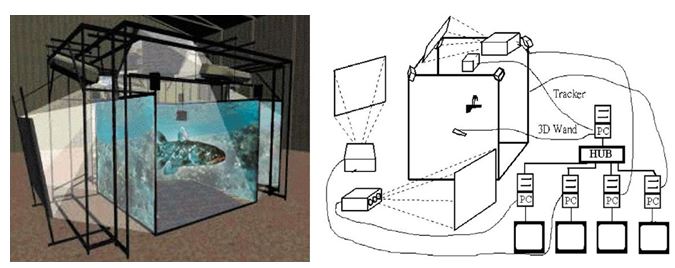

- 分散式CAVE系統:

工研院當時針對多人沉浸式虛擬實境,開發了一套類似CAVE(Cave Automatic Virtual Environment)的系統(如圖4),利用多部PC做分散式多顯示器的虛擬實境環境建構[4],使用者在一個立方體環境內,四個背投式顯示幕以四台投影機藉由反射鏡投影至前方、左方、右方及下方的投影幕上,使用者配戴遮罩式快門眼鏡(shutter glasses)與PC顯示同步,可獲得立體顯示的影像,同時透過手上的控制器(3D wand),藉由追蹤器追蹤觀看方向,並傳給四部PC控制四個投影畫面的同步更新,該系統可以多人同時進入該虛擬環境內觀賞(需配戴遮罩式快門眼鏡),由一人控制觀看角度,其他人可以自由觀看四個顯示畫面呈現的立體影像。此一系統並曾於多個展覽館建置,如台中科博館及屏東海生館,根據該館展示的主題提供相應的內容做虛擬實境的呈現(如圖中魚類之3D立體展示)。然而該系統的建置昂貴,雖然PC及主要軟體和內容開發由工研院完成,但投影機、反射鏡、投影幕及支架等仍仰賴國外系統。

圖4 工研院開發之CAVE虛擬實境系統

圖4 工研院開發之CAVE虛擬實境系統

- 3D Audio:

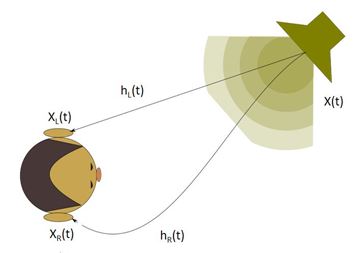

在聲響部分,工研院也投入相關3D Audio的技術,當時微軟(Microsoft)幾乎主導了所有相關多媒體的技術規格(如Direct3D、DirectSound3D),遊戲業者除了在畫質上需求越來越高,對音效的處理上也要求越來越高,畫質與繪圖效能由繪圖卡廠商根據微軟的規格各拚高低,同樣音效卡也根據微軟的規格加入許多音效的合成和加速功能,包括3D聲響(3D Sound)。為了要利用耳機(或喇叭)來模擬空間中(不只左右移動)的聲響效果,包括聲音距離遠近、都普勒位移(Doppler shift)等,利用音效卡的DSP來加速合成3D聲響成了重要的技術。然而要準確模擬人耳所接收的訊號相當困難,於是有所謂頭部相關傳輸函數(Head Related Transfer Functions, HRTF)的產生,利用一人耳的模型(雙耳),在裡面分別加入麥克風收音,然後在一無響室內的不同位置發出聲音,模擬不同位置的發出的聲源,分析左右耳所收到的聲音,包括左右耳時間差、左右耳聲音強度差及耳廓形狀造成之頻率振動等,不同聲源位置得到一組左右耳相關濾波器(如圖5)。

合成聲音時,根據頭部與聲源之間的相對關係,參考HRTF的對應濾波器,改變左右聲道的聲音大小、時間差及頻率,產生類似3D聲響的效果。此一技術對當時的遊戲設計有很大的影響,例如在第一人稱射擊遊戲中,聽到後方有敵人射擊的聲音,就可以改變方向朝後方尋找敵人位置,這在傳統遊戲聲效中僅有立體聲而無方向性有很大的差別。為減少計算複雜度,工研院利用DSP及研發不同濾波器來加速3D聲響合成的效果,兼顧音質及效能。

圖5 頭部相關傳輸函數(HRTF)示意圖

圖5 頭部相關傳輸函數(HRTF)示意圖新虛擬實境年代(2016~):

2016年號稱是虛擬實境元年,包括Facebook收購Oculus [5]、HTC跨足VR製作HTC VIVE [6]頭戴顯示器、Microsoft的Hololens [7]、而Google Cardboard [8]更讓虛擬實境只要手機加上便宜的透鏡就可以體驗,許多技術的突破讓硬體設備不再高不可攀,許多虛擬實境體驗店從大型遊樂場到個人遊戲等如雨後春筍般出現,隨著硬體的進步,運算能力越來越強,各種不同的感應器越來越普及,螢幕解析度越來越高,加上各種虛擬實境應用的興起,虛擬實境正在各種不同的應用領域發展開來。

360度視訊為VR一個主要的應用,看籃球賽、棒球賽、演唱會不在第一排,看不清球員及歌手的表情及動作,精彩好球及表演也無法近距離觀看,如果可以讓每個人虛擬坐在第一排,享受第一排清晰的視野,這是另一個虛擬實境可以提昇沉浸感的方法,從視覺上體驗更貼近表演者的情境 [9]。傳統上直播如果是在家觀賞,視訊開頭有幾秒的延遲對使用者不會造成困擾,只要後續畫面可以即時播放即可,工研院將此一技術提升至場內現場直播,即使坐在較遠的位置,仍然可以戴著頭盔享受在第一排的臨場感,然而此一應用對低延遲成像的要求極高,從多相機的視訊擷取,到360度影像貼合,到視訊壓縮編碼,透過無線網路傳輸,再到使用者端做視訊解碼,再依使用者觀看方向角度成像於頭戴顯示器上(如圖6),除了頭戴顯示器的互動成像處理需要低延遲外(如圖2所示),更加上從視訊擷取、貼合、壓縮、無線傳輸、解壓縮等所需耗費的時間,同樣需要低延遲才能讓觀看者不易察覺視訊的延遲。此外成像品質也是關鍵,例如影像貼合時因為不同相機得的影像會有所差異,所以必須校正與調整色調一致,還有網路傳輸的品質也會因為網路環境及設定而影響速度或封包遺失等問題,造成畫面品質不佳,因此整體系統在各個環節都需要考量。

未來沉浸感的增強研究

虛擬實境是一種全遮蔽式的模式,藉由隔離真實世界對感官的影響,提高對虛擬環境的沉浸感,但是這類的虛擬環境往往造成使用者在行動上的限制,因為所接收的畫面與真實世界的認知不同,加上無真實世界做參考,所以在操作移動上會因為害怕碰撞障礙物而有所遲疑,所以有另一類的虛擬實境產生—混合實境(Mixed Reality, MR),混合實境嘗試將真實世界與虛擬世界結合,不論是如Microsoft的Hololens [7] 在鏡片上投影虛擬物件,還是在頭戴顯示器上加入相機將真實世界影像和虛擬物件疊合,目的都是讓使用者可以觀察到真實世界,減少對全虛擬環境的不安全感。但是即便是混合實境,對沉浸感的需求仍然相同,主要的沉浸感依舊是從視覺和聽覺來,但重點卻是需要將虛擬物件(影像、聲音)和真實世界融合,達到真假不分的境界。工研院在未來的計劃中亦規畫了下述幾種增強沉浸感的研究,包括

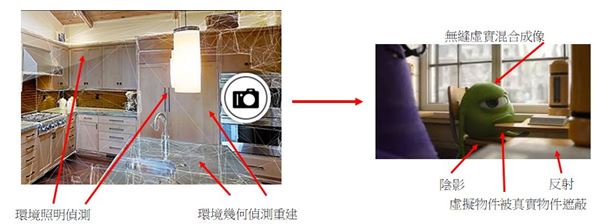

- 無縫虛實融合成像技術:

如圖7所示,為了將虛擬物件無縫融合至真實世界中,必須先建構真實三維環境的幾何模型,根據相機拍攝的畫面,偵測環境幾何並重建三維模型,在將虛擬物件置於重建之幾何模型中,如此可正確模擬虛擬物件與真實環境物件互相遮蔽的效果(虛擬物件遮蔽真實物件或真實物件遮蔽虛擬物件),但是若無相關環境照明資訊,將使虛擬物件與真實世界有明顯的差異,例如無陰影、無反射、明暗渲染與真實光源不一致等,為將虛擬3D物件無縫融合於真實環境中,實現高度沉浸與真實感之視覺體驗,透過對環境照明的偵測,推估可能的光源位置,將虛擬物件依偵測的照明資訊渲染,達到與真實環境一致的照明效果。

圖7 無縫虛實融合成像示意圖

圖7 無縫虛實融合成像示意圖

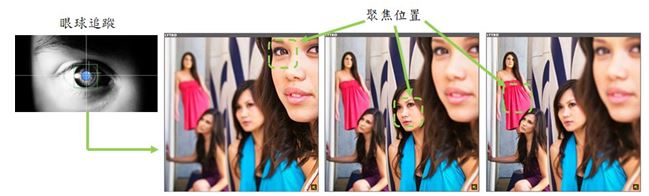

- 虛擬動態調焦成像技術:

如圖8所示,人眼具有自動調焦的功能,可以將焦點聚焦於不同距離以得到清晰影像,聚焦於近處則遠處相對模糊,聚焦於遠處則近處相對模糊,傳統頭戴顯示器因為顯示屏幕離眼睛很近,使得眼睛一直聚焦於螢幕上,因為無法分辨眼球注視位置,所以顯示內容亦無法產生相對的聚焦效果,近年來眼球追蹤技術漸漸成熟,其追蹤眼球注視位置的精確度小於1度 [10],若能根據所追蹤的眼球位置及環境偵測之幾何資料(真實或虛擬物件),就可以模擬人眼聚焦於不同距離所看到的畫面,讓配戴頭戴顯示器亦能獲得與真實世界人眼觀看的視覺效果,進一步提升混合實境的擬真度及視覺沉浸感。

圖8 虛擬動態調焦成像示意圖

圖8 虛擬動態調焦成像示意圖

- 動態空間聲響技術:

如圖9所示,在虛實融合的環境下,聲音(真實聲源或虛擬聲源)會受到真實世界及虛擬物件的影響而改變,例如虛擬聲源會受到真實場景的牆面、天花板或桌面而反射並進一步成為餘響,同理真實聲源也應該會受到虛擬牆面的影響而改變聽者收到的聲響,又因為隨著使用者的移動和轉動,環境的幾何一直在變動,所以動態的空間聲響合成才能營造出更接近真實的聲響沉浸感。

圖9 動態空間聲響示意圖

圖9 動態空間聲響示意圖虛擬實境對人體感官的影響主要來自視覺及聽覺,而視覺與聽覺的沉浸感決定了使用者對虛擬實境的體驗好壞,純虛擬實境創建一個虛擬環境,讓使用者與真實世界隔離,混合實境則需考慮真實世界與虛擬物件的融合,不論哪一種形式,擬真的視覺與聽覺效果可以大大縮短真實世界與虛擬世界的距離,讓虛擬實境的接受與應用可以更加普及。

作者介紹

李潤容(工研院 資通所 嵌入式系統與晶片技術組 技術副組長)

參考文獻

[1](2017) Hardlight VR. [Online]. Available: http://www.hardlightvr.com/

[2]R. Damianova. (2015) “The Nonverbal Abhinaya Codes As Foundation Of Performing Emotion,”[Online]. Available: http://manas.bg/bg/senses-and-sensuousness/nonverbal-abhinaya-codes-fondation-performing-emotion?l=en

[3](2017) Google Spatial Audio. [Online]. Available: https://developers.google.com/vr/concepts/spatial-audio

[4]W. J. Li, C. C. Chang, K. Y. Hsu, M. D. Kuo, and D. L. Way, “A PC-based distributed multiple display virtual reality system,”Displays, vol. 22, pp.177-181, 2001

[5](2017) Oculus. [Online]. Available: https://www.oculus.com/

[6](2017) HTC VIVE. [Online]. Available: http://www.htc.com/tw/vive/

[7](2017) Microsoft Hololens. [Online]. Available: https://www.microsoft.com/en-us/hololens

[8](2017) Google Cardboard. [Online]. Available: https://vr.google.com/cardboard/

[9](2017) Hyper Immersive Technology. [Online]. Available: http://www.hyperimmersion.com/

[10](2017) FOVE, Inc. [Online]. Available: https://www.getfove.com/

相關連結: 回 AR / VR 2017 面面觀 專輯目錄頁