無人機在各個領域的運用將會愈來愈廣,但在追求安全與操作簡單的前提下,發展更精進的避障防撞系統是關鍵。

無人機在各個領域的運用將會愈來愈廣,但在追求安全與操作簡單的前提下,發展更精進的避障防撞系統是關鍵。無人機(Unmanned Aerial Vehicle,UAV)類型多元,其種類包含定翼機(Fixed Wing)、多旋翼機(Multi-rotor)、單旋翼機(Single-rotor)與混合機(Hybird)等,除可執行危險任務外,亦可輔助專業人力執行任務以有效提升效率,因此近年整體市場蓬勃發展。近年各國對無人機在法規與政府專案上多有支持,其不拘於地形限制之特性使得應用上有許多想像空間,與人類生活、智慧生活發展更加息息相關。例如日本規劃2030年之前實現「完全無人運輸和配送服務」;2018年5月美國交通部(USDOT)從各州政府選出 10 個無人機專案作試行,包括包裹運輸、飛機檢查、安全監控等;英國Flying High Challenge計畫則應用無人機處理包括醫療遞送、交通事故、建設進度觀察等領域。

需求五花八門 完善避障系統是必備

現階段無人機在航拍、資訊蒐集、巡檢、監控等應用服務領域的發展速度最快,並已形成可營利的商業模式,進而帶動工業及專業級無人機市場成長。但事實上,無人機的應用仍存在技術上的瓶頸,例如常用於可懸停拍攝之多旋翼機缺乏機體安全、通訊安全及避障等機制,且續航力普遍不足(多為30分鐘以下),成為無人機應用擴散之首要限制。此外,目前無人機及酬載操作仍以遙桿為主,場域主難以學習運用,相關作業亟待簡化。最後,蒐集的相關影像訊息,若能更有系統的儲存分析,將可為無人機應用服務產業帶來更大的應用價值。

最值得注意的是,在無人機計畫團隊與各類場域主討論無人機應用需求時,常常發現無人機於各類案場執行飛行時,會具有不同特殊避障需求,例如工程場域之案主要求無人機於巡檢時,需與建築主體持續維持某個特殊距離或者角度,以避免可能的碰撞;於隧道昏暗場域,要能夠主動避開原有障礙物持續飛行,甚至要能閃避如蝙蝠等飛行動物,才能在視線不明的情況下完成巡檢任務;巡視鐵塔等案場,須能夠避開微細的電線,以避免被細微物纏繞而導致危險;噴灑農藥時,為了精準的噴灑於正確的農作物上,無人機需保持在農作物上1~2公尺的距離,以避免重複噴灑農藥問題。由於無人機可避障的角度多達前、後、左、右、上、下六個方向,因應不同需求,所需解決的技術重點亦有不同,故避障技術成為無人機發展裡的重要議題。

除了場域上的特殊需求之外,無人機避障能力是實現各類自動化飛行與智慧化編隊的關鍵,完善的避障系統可以有效降低操作失誤的損失與引發的後續糾紛,降低損傷及事故發生率,故國際上知名的無人機廠商(如DJI)紛紛精進避障系統,預計將在未來幾年趨於完善,成為商業應用無人機的標準配備。

1. 四種主要避障技術 各有勝場

「測距」為避障的基礎,只要無人機能夠測量出與障礙物之間的距離,就可以在撞向障礙物之前停止前進,現階段有多種技術可以實現測距;以目前各家廠商的作法觀之,無人機避障系統主要有以下做法,分別是超音波(Ultrasonic)、紅外線(Infrared,IR)、飛時測距(Time of Flight,ToF)、以及立體視覺(Stereo Vision)。以下簡單介紹:

1.1超音波(Ultrasonic):不受光線、粉塵、煙霧干擾,多方向偵測

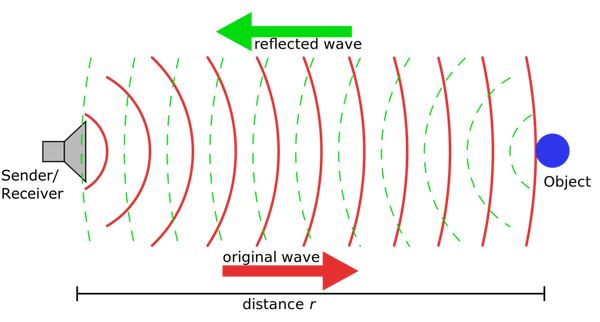

超音波可以在空氣中、液體或固體中振動傳送,應用於各類領域已久,例如醫療、聲納、測距等,是最簡單的測距作法,被許多測距系統使用。超音波應用於無人機的做法通常是加裝定向的超音波發射和接收器,再將其接入飛控系統即可。一般應用上,超音波避障系統具有不會受到光線、粉塵、煙霧干擾的優點;但是,如果物體表面反射超音波的能力不足,避障系統的有效距離就會降低,安全隱患會顯著提高。一般來說,超音波的有效距離是5公尺,對應的反射物體材質是水泥地板,如果材質不是平面光滑的固體物,比如說地毯,那麼超音波的反射和接收就會出問題。

圖1 超音波測距原理示意圖

圖1 超音波測距原理示意圖1.2 紅外線:便宜,容易使用

一般的紅外測距都是採用三角測距的原理。紅外線的運作方式,是從測距儀發出紅外線後,碰到反射物被反射回來,再根據發出到被接受到的時間與紅外線的傳播速度兩個參數就可以算出距離。紅外測距的優點是便宜、容易使用、安全,缺點是精度低、距離短、方向性差。

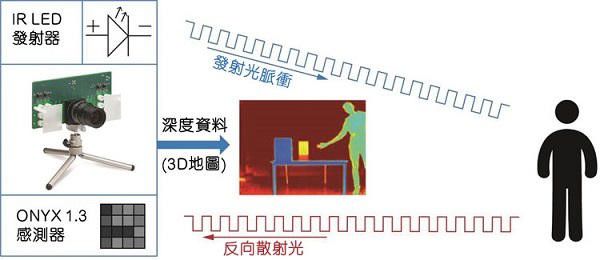

1.3飛時測距:探測距離遠、掃描速度快、抗光干擾性佳

原理與超音波類似,即把音波轉為光波。透過紅外線折返的時間去計算跟物體之間的距離,以得出3D景深圖。優點是探測距離遠、掃描速度快、抗光干擾性佳,但是具有準確度有限及體積過大缺點。目前應用極廣,包括醫療檢測、工業用機器視覺、手機、無人機、遊戲機、AR/VR及智慧車的光達測距技術等。

圖2 ToF測距原理示意圖

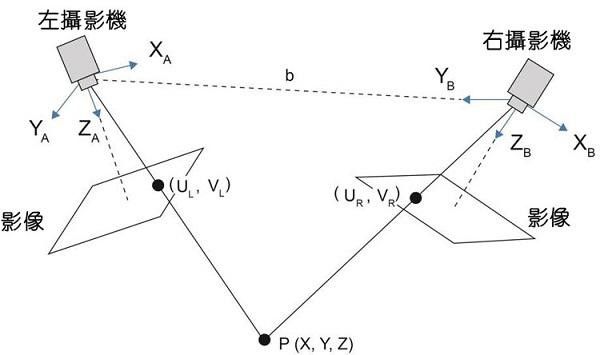

圖2 ToF測距原理示意圖1.4立體視覺:省電

立體視覺法類似於雙眼目測距離的原理,以2架或2架以上的攝影機來取得物件的不同視角,並以進行三角測量法取得與物體之間的距離資訊。立體視覺的優點是省電、適用於光線充足的環境;缺點是軟體演算法複雜、延遲性高,且不適用於昏暗或光線變化多的情況,辨識度很大程度上取決於物件的反光特性。

圖3 立體視覺測距原理示意圖(資料來源:EETTAIWAN)

2. 國際無人機廠商現行採用的避障系統

由於無人機因應不同環境有各類避障需求,現國際間的無人機業者也開始著重於附加避障防撞的功能於其產品中,像是大陸的大疆(DJI)、零度(Xiro)、極飛(Xaircraft),以及美國的昊翔(Yuneec)、Panoptes Systems皆有提出其相應的方案(如表1),大多採用了複合式的作法,以利各類技術可以互補,達到最好的避障效果。

目前商用無人機市占率最高的大疆,針對不同應用採用了不同方案。空拍機型(如Phantom 4 Pro、Inspire 2)在不同方向分別採用了立體視覺、紅外線和超音波感測器,其最遠感知距離為30公尺,惟在昏暗環境下避障無法運作,且較低階的機種僅能針對前方進行避障;另在農業用無人機則採用了毫米波雷達來偵測地貌,但其限制飛行速度需小於18km/hr。零度的Xplorer 2採用了TOF攝像儀(Time-of-flight Imager),在無人機停旋時進行水平360度障礙感知,但飛行前進只能偵測前方6公尺內障礙物;極飛則結合了立體視覺和毫米波雷達,僅針對前方和下方障礙物進行感知。

美國的昊翔則是與英特爾(Intel)合作,採用了Intel Realsense R200感知技術,再加上超音波感測器,可以進行前方的避障,但在戶外強光下,其Realsense所使用的紅外線會受到干擾;至於新創的Panoptes Systems則是提出了電子保桿概念,在其產品eBumper4上安裝了四向的超音波感測器,用於偵測4.5公尺內的障礙物,且受限於超音波易受環境音干擾的問題,採用eBumper4的無人機,其飛行速度需小於9.3km/hr,避障功能才能有效運作。

表1 三維避障防撞技術比較

| 廠商 |

Panoptes Systems Bumper4

(美國)

|

Xiro Xplorer 2

(中國)

|

Yuneec Typhoon H

(美國)

|

DJI Phantom 4 Pro

(中國)

|

DJI Inspire 2

(中國)

|

DJI MG-1S / MG-1S Advanced

(中國)

|

Xaircraft Xcope

(中國)

|

| 感知技術 |

超音波回聲定位感應器 |

TOF (Time-Of-Flight) Imager |

超音波 + 主動式立體視覺 |

立體視覺 + 紅外線 + 超音波 |

立體視覺 + 紅外線 + 超音波 |

毫米波雷達 (24G) |

立體視覺 + 毫米波雷達 |

| 感知距離/方向 |

4.5 m (左、右、前、上) |

6 m (360°) |

前方 |

0.7 ~ 30 m (前後);0.2 ~ 7 m (左右) |

0.7 ~ 30 m (前);0 ~ 5 m (上);10 ~ 500 cm (下) |

1.5 ~ 30 m (前、後);下方 |

20 m (前);30 m (下) |

| 技術限制 |

飛行速度 ≤ 9.3 km/hr;易受環境聲音干擾 |

飛行前進只可偵測前方障礙物 |

紅外線易受戶外強光影響 |

在昏暗環境下無法運作 |

在昏暗環境下無法運作 |

飛行速度≤ 5m/s |

|

資料來源:資通所無人機計畫

3. 三維避障的三階段技術開發

資通所於無人機之避障安全系統融合低功耗及輕量感知裝置,包含立體視覺、光達、超音波等,結合深度學習依序發展前向偵測、五向偵測、夜間環境及細微物(如電線)之避障技術,以完善場域需求,達成各種任務。無人機計畫以三階段做為進程,以利符合預定規畫之應用場域需求(警用、工程巡檢),未來可擴大使用範圍;目前技術發展仍處於第一階段中期。三階段之目標如下:第一階段為完成三維環境感知避障,融合影像及感測器;第二階段則將避障範圍擴充到五向感測,並達成目標物環繞避障、等距環繞飛行;第三階段則規劃可閃避細微障礙物,如電線電桿,並可自主閃避相關飛行物體。

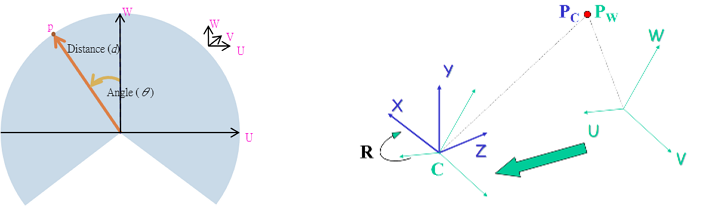

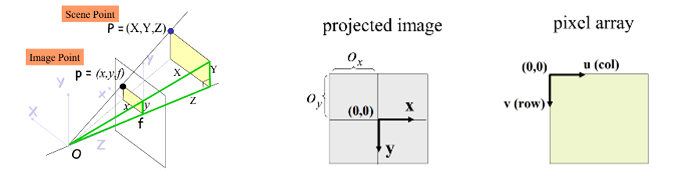

第一階段為完成環境感知避障,融合影像及感測器。為測量物體距離及大小,本計畫擬整合光達(LiDAR)及攝影機,以光達進行距離量測,另使用攝影機取像並進行物體偵測。首先需解決光達測距點和攝影機像素點間之對應關係,如下圖所示:

圖4 光達與攝影機之空間座標系(資料來源:資通所無人機計畫)

圖4 光達與攝影機之空間座標系(資料來源:資通所無人機計畫)本計畫進一步提出機構設置建議及空間座標轉換方法,規劃作法如下:

步驟一:將光達和攝影機儘可能垂直或水平靠近排列,並使其正面皆朝向同一方,以使得光達掃描範圍和攝影機可視區域有較大的重疊。

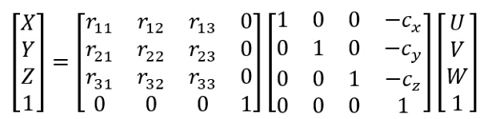

步驟二:以光達掃描中心為3D空間座標原點,將每一測距點(d,θ)轉換為3D空間座標(U,V,W),由於機構設置的關係,光達和攝影機間存在著一定的偏移,故透過位移和旋轉將光達的3D座標軸對齊至以攝影機光學中心為原點的3D座標軸,此時新座標為(X,Y,Z):

圖5 計算測距點新座標

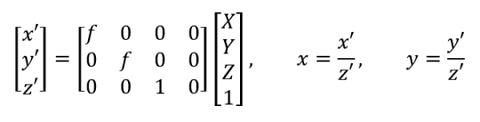

圖5 計算測距點新座標步驟三:利用攝影機成像原理,將3D座標透視投影轉換至2D座標,此時將得到投影成像上的(x,y)座標:

圖6 計算投影成像的座標

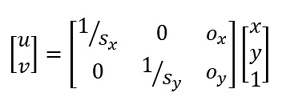

圖6 計算投影成像的座標步驟四:由於攝影機最後成像的感光元件,與影像座標間也存在著大小比例及原點偏離,故再將成像上的(x,y)座標轉換至像素座標上的(u,v):

圖7 計算成像上座標轉換為像素座標

圖7 計算成像上座標轉換為像素座標 圖8 透視投影及攝影機成像示意圖(資料來源:資通所無人機計畫)

圖8 透視投影及攝影機成像示意圖(資料來源:資通所無人機計畫)經上述步驟,在預先設置好的機構上進行校正後,即可將光達量測之距離數據與攝影機畫面之影像進行疊合。為克服光達資料點鬆散及單平面感測涵蓋面積不足之問題,本計畫預計再採用影像分割(Image Segmentation)方法,抽取畫面中相鄰之區域,並與光達數值疊合,估算出物件距離及大小,進行採行避障策略。

第二階段提出超廣角五方向感測,主要是因為在考量重量、耗電、抗環境影響、感知區域面積、價格等因素後,採用多方向的立體視覺感測器,結合光達等多重感知融合,提供前、後、左、右、上方10公尺的感知距離,並可於飛行速度20km/hr以下的狀況在1秒內完成旋停程序。

避障防撞技術上,發展立體視覺結合光達(LiDAR)之環境感知技術,使無人機可即時感知周遭環境,完成閃避障礙物與細部執勤路徑規劃,確保近距檢測之飛行安全。也透過IR攝影機與背景光源校正,克服光線強弱干擾,達到日夜間安全執勤。

超廣角五方向感測。作法上將於水平二軸四方向各配置一組感測器(含立體視覺感測器和光達),利用較廣角的光達進行水平360度障礙感知,再使用立體視覺感測器進行測距和物體偵測,並融合兩者數據得到較高精度的障礙物資訊;另外,上方的障礙物以遮蔽物為主,將於無人機軸臂上方設置朝上的感測器,以達到第五向的障礙物感測。依據此配置完成的避障感知硬體雛形,如下圖所示:

圖 9 超廣角五方向避障感知硬體雛形(資料來源:資通所無人機計畫)

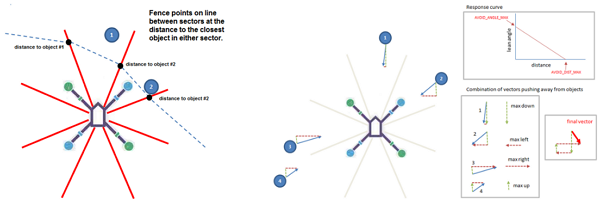

圖 9 超廣角五方向避障感知硬體雛形(資料來源:資通所無人機計畫)在進行360度全向感測後,將感測區劃分為多個小區,依據各個小區的障礙物分佈,動態連結成虛擬電子圍籬,再以遠離此虛擬圍籬的策略計算飛行方向來進行障礙物閃避(如下圖,動態虛擬電子圍籬和脫離方向計算)。

圖 10 動態虛擬電子圍籬和脫離方向計算(資料來源:資通所無人機計畫)

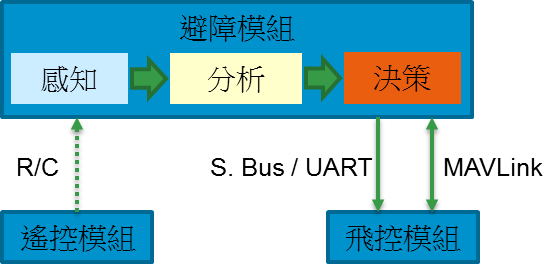

圖 10 動態虛擬電子圍籬和脫離方向計算(資料來源:資通所無人機計畫)同時為了能夠因應不同場域的避障需求,本計畫進一步提出避障模組和無人機飛控模組的協同作業方式(如下圖,避障模組和飛控模組的協同作業),規劃作法如下:

- 手動飛行:偵測到前進方向障礙物時,攔截遙控訊號並依決策轉送修改後的數據,完成停旋或繞路。

- 自動飛行:偵測到前進方向障礙物時,透過MAVLink指示飛控模組進行閃避或停旋。

圖 11 避障模組和飛控模組的協同作業(資料來源:資通所無人機計畫)

圖 11 避障模組和飛控模組的協同作業(資料來源:資通所無人機計畫)另為克服攝像頭在低光源下分辨率不佳的問題,將配合紅外光源來改善,提供更佳的夜間避障能力,以達到全方位避障防撞之目的。

第三階段則規劃可閃避細微障礙物,如電線電桿,並可自主閃避相關飛行物體。

前一階段基於距離感測的全向避障技術,已可在簡單環境下完成自主飛行,但在複雜環境下,由於物件的種類和分佈都更為多樣,同時受限於感測器的分辨率,細微障礙物的感知趨於困難,因此導入人工智慧技術為第三階段的主要任務,針對特定物件(如電線桿、電線、樹枝、牆壁等),發展特定物件偵測模組,及時反饋閃避、提升飛行安全。

應用物體和人像辨識、圖像追蹤等技術皆可以改善複雜環境下的自主避障飛行,但透過傳統固定演算法的方式來辨別或追蹤物件,容易因無人機飛行時物件特徵變化過大,造成辨識失敗或無法追蹤;採用深度學習的技術,透過訓練的方式,讓無人機學習跟蹤物件的樣貌特性,當無人機飛行時,由於已習得物件特性,即使物件識別角度不同,也無須再添加額外的演算法,大幅提高成功率。

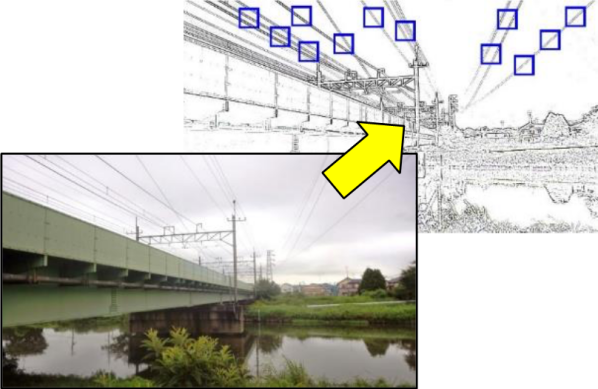

目前人工智慧主要著重於影像辨識功能,透過感測器蒐集環境中的不同資訊,再藉由GPU運算影像,以得知環境中的狀況。以無人機進行市區飛行或農噴時可能遇到的細微障礙物「電線」為例,測距感測器不容易完整偵測到電線的存在,測距演算法也容易將其視為干擾而濾除。需使用深度學習模型,給予大量的各式電桿和電線(如電力電桿、電信電桿、高壓電塔等)圖像資料,經由適當的訓練,無人機可透過攝像頭的即時影像偵測出電桿/電線結構,再藉由此結構的已知尺寸資訊,並輔以全向測距感測器的結果進行數據融合,即可得到此電桿/電線結構的三維空間位置。

圖 12 基於深度學習障礙物感測技術的電線偵測(資料來源:資通所無人機計畫)

圖 12 基於深度學習障礙物感測技術的電線偵測(資料來源:資通所無人機計畫)由於深度學習演算法需要大量的重覆性運算,為了能夠實時運行,此避障系統將採用硬體加速平台來進行開發,目前投入該技術平台的公司有NVIDIA、高通與英特爾(Intel)等,其中NVIDIA Jetson TX2和Intel Movidius Neural Compute Stick皆為符合無人機所需重量輕、耗電低的嵌入式設備。

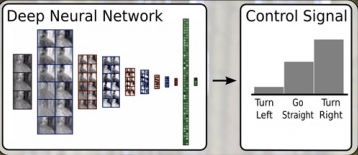

人工智慧除了用於影像辨識外,還可以幫助無人機改善控制、導航與路徑規畫等功能。一般無人機以偵察和和避開障礙為主,但結合前述測距感測、影像辨識、物件追蹤等技術,無人機可以完成動態描繪地圖、導航和計劃路線,透過人工智慧技術,同時參照四周環境的資訊,作出智能的決定和流暢的行動,近似專業機師的判斷,而導航部份則是以更有效率的方法前往目的地。

圖 13 人工智慧參照四周環境資訊,進行智能導航(資料來源:資通所無人機計畫)

圖 13 人工智慧參照四周環境資訊,進行智能導航(資料來源:資通所無人機計畫)追求安全、操作簡單 避障防撞技術更精進

為了因應不同的環境,當前無人機的避障還有許多問題待克服,國際上也有許多廠商開展此類研究。為了實現完善的避障功能,從軟體到硬體都須克服許多的難題,包括須可以穩定地在計算能力和功耗都有限制的平台上運作、各類測距工具的特性如何最有效的應用、可適用於環境的變化,屬於十分困難的技術。但長遠看來,無人機若要普及,適用於保全、農業、建築、運輸、娛樂等領域,智慧化的避障防撞技術肯定是必經之路。相信未來會有各類型的解決方案應用於無人機避障,有了這些技術的輔助,無人機的操作也將越來越安全,越來越簡單。

參考文獻

[1]Bregu, E., Casamassima, N., Cantoni, D., Mottola, L., & Whitehouse, K. (2016, June). Reactive control of autonomous drones. In Proceedings of the 14th Annual International Conference on Mobile Systems, Applications, and Services (pp. 207-219). ACM.

[2]Di Stefano, L., Clementini, E., & Stagnini, E. (2017, September). Reactive Obstacle Avoidance for Multicopter UAVs via Evaluation of Depth Maps. In International Conference on Spatial Information Theory (pp. 41-43). Springer, Cham.

[3]Yang, S., Konam, S., Ma, C., Rosenthal, S., Veloso, M., & Scherer, S. (2017). Obstacle avoidance through deep networks based intermediate perception. arXiv preprint arXiv:1704.08759.

[4]Aguilar, W. G., Casaliglla, V. P., & Pólit, J. L. (2017). Obstacle avoidance based-visual navigation for micro aerial vehicles. Electronics, 6(1), 10.

[5]O'brien, J. J., Natarajan, C., & Jones, N. G. (2018). U.S. Patent Application No. 15/723,889.

[6]Chakravarty, P., Kelchtermans, K., Roussel, T., Wellens, S., Tuytelaars, T., & Van Eycken, L. (2017, May). CNN-based single image obstacle avoidance on a quadrotor. In Robotics and Automation (ICRA), 2017 IEEE International Conference on (pp. 6369-6374). IEEE.

[7]Smolyanskiy, N., & Gonzalez-Franco, M. (2017). Stereoscopic first person view system for drone navigation. Frontiers in Robotics and AI, 4, 11.

[8]Zhilenkov, A. A., & Epifantsev, I. R. (2018, January). System of autonomous navigation of the drone in difficult conditions of the forest trails. In Young Researchers in Electrical and Electronic Engineering (EIConRus), 2018 IEEE Conference of Russian (pp. 1036-1039). IEEE.

[9]O. Zakaria, B. Alaa, M. Fouad and M. Hicham. Deterministic Method of Visual Servoing: Robust Object Tracking by Drone. 2016 13th International Conference on Computer Graphics, Imaging and Visualization (CGiV), Beni Mellal, pp. 414-422.

[10]H. Yadav, S. Srivastava, P. Mukherjee and B. Lall. A real-time ball trajectory follower using Robot Operating System. 2015 Third International Conference on Image Information Processing (ICIIP), Waknaghat, pp. 511-515.

[11]E. Páli, K. Máthé, L. Tamás and L. Buşoniu. Railway track following with the AR.Drone using vanishing point detection. 2014 IEEE International Conference on Automation, Quality and Testing, Robotics, Cluj-Napoca, pp. 1-6.

[12]J. Pestana, J. L. Sanchez-Lopez, P. Campoy and S. Saripalli. Vision based GPS-denied Object Tracking and following for unmanned aerial vehicles. 2013 IEEE International Symposium on Safety, Security, and Rescue Robotics (SSRR), Linkoping, pp. 1-6.

[13]M. Barajas, J. P. Dávalos-Viveros, S. Garcia-Lumbreras and J. L. Gordillo. Visual servoing of UAV using cuboid model with simultaneous tracking of multiple planar faces. 2013 IEEE/RSJ International Conference on Intelligent Robots and Systems, Tokyo, pp. 596-601.

[14]S. Stolle and R. Rysdyk. Flight path following guidance for unmanned air vehicles with pan-tilt camera for target observation. Digital Avionics Systems Conference DASC '03 the 22nd, Indianapolis, USA, pp. 8.B.3-81-12 vol.2.

[15]Chi‐Huang Shih, Chun‐I Kuo, Ce‐Kuen Shieh, Yeh‐Kai Chou (2014). Small‐block interleaving for low‐delay cross‐packet forward error correction over burst‐loss channels. International Journal of Communication Systems, vol. 27, no 12, pp. 3980-3995.

[16]M. Claypool and Y. Zhu. Using interleaving to ameliorate the effects of packet loss in a video stream. Proceedings of ICDCSW '03. Providence, Rhode Island, USA, pp. 19-22.

[17]R. Razavi, M. Fleury, and M. Ghanbari (2009). Adaptive packet-level interleaved fec for wireless priority-encoded video streaming. Adv. MultiMedia, vol. 2009, pp. 3:1-3:14 .

[18]BUSSINESS NEXT. [Online]. https://www.bnext.com.tw/ext_rss/view/id/835804

[19]NOWNEWS. [Online]. https://www.nownews.com/news/20171025/2631514/

[20]EETTAIWAN. [Online]. https://www.eettaiwan.com/news/article/20180316TA31-3D-imaging-time-is-right-for-ToF

[21]read01. [Online]. https://read01.com/3G5AxzA.html

相關連結: 回175期_智慧城市智能感知與物聯網專輯