工研院資通所 李國徵 陳瑞文 徐雅蕙 劉翠萍 張瑞玲 黃瑞星 吳俊賢 張傑智 邱碧貞

工研院微系統中心 李家昶

高齡者智慧照護需求是未來趨勢,居家服務機器人將可代替子女照護獨居父母,讓銀髮族真正擁有便利安全的樂齡生活。

高齡者智慧照護需求是未來趨勢,居家服務機器人將可代替子女照護獨居父母,讓銀髮族真正擁有便利安全的樂齡生活。台灣於2018年開始邁入高齡化社會,各縣市政府積極規劃透過產品展、媒合會、論壇或其他創意推廣活動,促進銀髮產業發展及市場開發,打造智慧銀髮樂齡城市。如何讓一個健康的銀髮長者在居家中享有便利、安全與愉快生活,居家服務機器人就是落實居家健康照護新選擇。

樂齡活躍不悲情 高齡者智慧照護需求與機會大增

根據IEK預估,2026年台灣65歲以上人口將成長至470萬,占臺灣人口五分之一;2016年台灣高齡長輩(70歲以上)約200萬人,八成以上屬於健康(go-go族)及亞健康(slow-go族),拜國內醫療照護完善之賜,平均壽命得以延長,伴隨而來的高齡者生理機能退化及慢性疾病增加議題,也為業者帶來無限想像的銀髮新商機。以往全球對高齡族群需求,多從弱勢角度出發,以社會福利角度提供解決方案。近年來高齡者即等於依賴者的形象,已逐漸轉變為正向積極作為,除提供照護醫療等社會福利外,更進一步規劃協助高齡族群安心生活、健康生活、行動生活、社交生活,以自立、自尊、維持人際關係、社會參與,更進一步發揮智慧與再貢獻,讓高齡族群逐漸成為國家競爭力主要來源之一。透過各種科技應用及創新創業諮詢服務體系,整合在地生活服務,打造安全、友善、安老的居家與社區環境和生活守護陪伴服務來支持老年生活。創造具幸福感的樂齡生活,建構活躍愉悅高齡社會,已成為全球發展趨勢。

根據主計處調查,黃金世代(出生於1946~1964年)平均每人年所得約57萬元至64萬元間,居各個年齡層之冠,平均一年消費額高達1.3兆元,被認為是未來15年消費潛力最雄厚的世代。黃金世代已逐漸步入老年,意味著將產生大量的退休潮與老人人口爆炸現象,這不僅是社會議題,也將伴隨莫大商機。黃金世代人數眾多,財富、教育及思想觀念都比現在的銀髮族更開放,重品質、敢享受、願意用消費回饋自己。由於醫療技術發達,平均壽命延長,使得黃金世代更有能力及時間來消費,這種人口結構與特質的改變,也是全球銀髮市場商機的主因之一。此外,少子化、高齡化與家庭結構改變,高齡獨居成為社會趨勢,黃金世代因仍具有傳統華人孝道觀念,對於與父母分隔兩地,無法陪伴關心、擔心獨居父母的安全、健康而無法及時伸出援手、提供父母生活協助等,是其生活中顯著的痛點;黃金世代父母則因獨居產生孤獨感,隨著身心退化愈需更多生活協助,希望獲得子女更多的關心與協助。由於科技的進步,已有業者開始透過各項輔具或服務提供生活協助,惟服務破碎散落,加上高齡長者對於新科技的不熟稔與使用者介面的困難,因此高齡長者與其關聯家庭間的需求痛點仍遲遲無法解決。

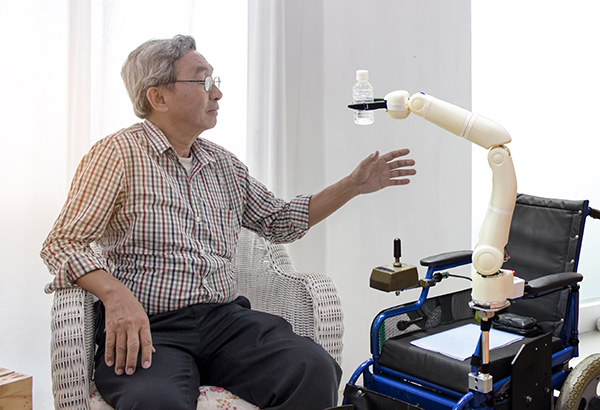

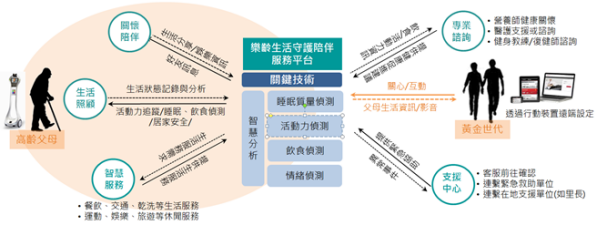

有鑑於市場趨勢、黃金世代與高齡父母間的需求,工研院研發國內首創華人銀髮族群專用且具備主動守護與陪伴關懷能力之應用服務系統與整體解決方案,以科技加強銀髮族的家庭社交聯繫;以Ambient Intelligence感知睡眠、活動力、情緒及飲食品質,誘發子女、朋友關懷的議題。透過生活型態變遷與趨勢掌握,發展環境智能整合系統與服務、以共通平台發展垂直應用智慧服務。

圖1 樂齡生活守護陪伴服務示意圖

圖1 樂齡生活守護陪伴服務示意圖「樂齡生活守護陪伴服務」將發展我國首創銀髮族群專用具主動守護與陪伴關懷能力之應用服務系統與整體解決方案,以Ambient Intelligence為核心,發展全方位音訊分析、居家活動感知分析、居家飲食影像檢測分析系統等3項自主研發關鍵技術,同時結合O2O新樂齡商業生態系推動,帶動銀髮智慧終端與服務新產業起飛,成為華人生活圈樂齡生活智慧服務典範。搭配依據服務、技術發展及商業合作推動時程,續以「遠距智慧操控」、「身心智能感知」、「日記自動生成」、「第三方服務擴充」等作為各年階段性目標,陸續完成終端雛形發展及生態系推動、核心夥伴合作驗證、整體解決方案之服務驗證等產業化推動工作。

樂齡陪伴機器人之智能感知技術應用

目前國際上主要研發家用型服務機器人的廠商有華碩的Zenbo、宏碁的Jibo、夏普的手機人型機器人RoBoHoN、軟銀的Pepper……等產品(如圖2所示)。宏碁的Jibo與夏普的RoBoHoN目前不具備移動能力,以提供控制家中的電子產品、影音與通信等功能為主;軟銀的Pepper以商用為主,提供客服接待與產品介紹等功能,家用方面目前以對話聊天為主要訴求,尚無服務特定對象;華碩的Zenbo目前鎖定居家生活應用,並特別為孩童提供陪伴、學習和照護服務。顯示我國企業己具備智慧載具硬體代工設計與製造能力,部分企業甚至更具備系統研發與整合能量,唯AI軟體技術仍多受限於國外等大廠,工研院期望可藉由語音與影像等AI相關關鍵軟體技術,帶動國內家用服務型機器人產業之發展。

圖2 家用機器人功能分析

圖2 家用機器人功能分析從50到64歲的黃金世代,是目前台灣最富有的世代,他們最大的痛點是工作繁忙,無法陪在居住於老家的父母身邊,以盡孝道。本服務的目標使用客群是黃金世代的高齡長者,在人機互動的產品設計上,結合相關領域專家,包括:高齡健康管理、高齡陪伴照顧、高齡心理、工業設計等領域,透過跨領域專業合作,設計貼近目標客群的創新服務解決方案。經專家意見回饋影響老人健康最重要的因素是睡得好、活動夠、心情好、吃得好。工研院針對關鍵因素替黃金世代子女發展一套「我在你身邊」主動守護陪伴關懷的系統與服務(服務情境示意圖如圖3所示),來協助他們了解父母的健康與生活,其核心主要技術包含:

圖3 樂齡生活服務情境示意圖

圖3 樂齡生活服務情境示意圖一、睡得好:睡眠品質分析技術觀察父母睡眠狀態,確認睡眠品質

關於國際上睡眠品質評估方式,主要分為自我主觀評量、客觀儀器測量,以及睡眠觀察三類。主觀評量法藉由主觀的事後問卷調查受試者睡眠總時間、睡眠品質與睡眠困擾等問題,依據主觀的感受作為評估依據,測試結果易受受試者主觀感受影響,許多睡眠中的疾病與現象無法藉由主觀評量而得知;客觀儀器測量最常使用睡眠多項生理檢查儀(Polysomnography, PSG),這是目前最詳細準確的測試方式,包括心電圖、腦波、眼電圖等項目,然而受測者必須在特定的實驗室進行睡眠測試,身上大量的感應電極與訊號線妨礙睡眠,十分不便,近年來所流行的智慧手環,也有類似的量測功能,但並不準確;睡眠觀察則是藉由醫護人員或實驗人員從旁觀察受試者的睡眠狀態,好處是不會因儀器妨礙原本的睡眠行為,但需要大量的人力與時間進行觀察與紀錄,雖然也可以藉由攝影記錄的方式減少人力負擔,但是睡眠觀察所耗費的成本頗大,所觀測的結果僅能作為總睡眠時間、睡眠活動、與某些特定睡眠疾病的觀察,相對而言較不符合效率。以上這三類的評估方式,均需要在專業的睡眠醫療中心進行,才能獲得客觀的評估結果。

有鑑於上述問題,工研院研發非接觸式的睡眠品質分析技術,在不干擾受試者睡眠的前提下,在居家睡眠環境中長期持續性地監測受試者的呼吸頻率、心跳頻率、翻身、起床動作等多項外顯行為,分析受測者睡眠歷程,睡眠中覺醒次數、淺眠階段時間、深眠階段時間等睡眠品質的重要指標,評估受試者自身的睡眠品質。技術內容包含:

- 睡眠品質分析系統需求規格確立:進行長者睡眠環境與情境的探討分析,以確立睡眠品質分析的情境,並進行睡眠品質分析系統的需求規格設計。包含:睡眠環境中的Wi-Fi設備佈署方式、運作情境、分析結果內容、睡眠障礙等級、睡眠問題可能性等等。

- 睡眠品質參數分析演算法設計:同時會根據長者居家Wi-Fi環境所能擷取到的Wi-Fi無線通道資料,進行睡眠品質參數(呼吸頻率、翻身事件、起床事件)分析演算法的設計與模擬驗證。

- 睡眠品質參數分析雛型系統建立:使用Intel 5300 Wi-Fi設備與一般商用的Wi-Fi終端,進行Wi-Fi上行通道資料的收集擷取工作,之後再實作睡眠品質參數(呼吸頻率、心跳頻率、翻身起床事件)分析演算法於睡眠品質分析伺服器端,以計算長者在夜間睡眠時期的呼吸頻率、心跳頻率與翻身起床次數這幾項睡眠品質參數。

本技術在LOS(line of sight)的環境下,使用非接觸式的偵測技術,進行一位長者在夜間睡眠期間的翻身、起床事件偵測,準確率可達80%,與一人心跳、呼吸頻率量測,準確率可達60%。

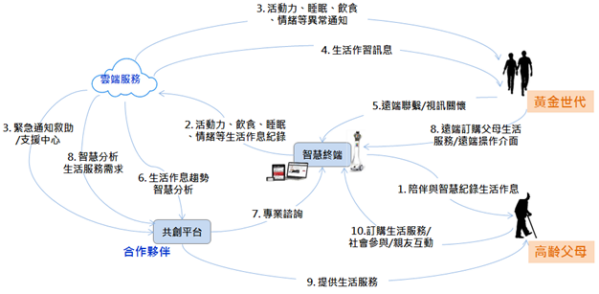

二、活動夠:居家活動力技術分析觀察父母日常活動,即時預防與救護

現有照護型機器人功能著重於監看、錄影,以及語音通話等,其功能僅可讓一般民眾遠端遙控,監看家中長者動態等,並無法主動感知長輩的活動及異常狀態。目前常見偵測長者跌倒的技術多採用配戴各類感測器進行數據分析,當超過某一臨界值則判斷為跌倒,此類方法有容易與日常活動混淆的缺點。因此,工研院發展一個可以分析獨居長者日常生活行為,發展智能感知技術於無形中蒐集使用者生活作息數據,分析生活型態、活動行為與情緒,讓無法隨侍在側的子女可以掌握高齡父母的身心與生活狀態,得以即時關心或協助;透過智慧型照護機器人進行智慧分析技術,及早發現長者異常行為,提早預防與治療。

居家活動力技術分析示意圖如圖4所示,傳統的跌倒偵測系統多半都建立在3D加速陀螺儀的應用上,本計畫預計使用一般視訊擷取設備作為取像裝置去偵測老人活動狀態,採用基於深度學習之影像分析技術,分析長者姿態外型的差異,進而提供異常運動狀態決策,出門在外的子女可以透過APP所匯集的資訊,觀察父母的活動狀況及預防異常狀態,並依緊急程度主動通知子女發生事件,掌握事件處理之黃金時間。技術內容包含:

- 穩健人形偵測:由於室內環境因空間侷限或家具阻擋,常造成人體局部遮蔽導致偵測失敗,本計畫將採用基於單一卷積神經網路(Convolutional Neutral Network, CNN)進行室內人形偵測與辨識,可在居家環境完成穩健人形偵測任務。

- 跌倒姿態辨識:本計畫將透過預先收集的動作資料庫(Action recognition dataset),進行含有時間資訊的動作特徵擷取,並將取得的特徵結合支持向量機(Support vector machines, SVM)和深度學習(Deep learning)方法進行訓練,搭配人形偵測技術,可在不限制背景的居家環境進行跌倒行為偵測。

圖4 居家活動力分析示意圖

圖4 居家活動力分析示意圖目前國內在照護機器人的應用主要以學研單位開發為主,為加速技術實際應用至產業,本技術可結合國內監控廠商(如京晨、貓捉老鼠、一二三視等),以開放系統SDK形式,推動居家安心照護與關懷以達成產業化目標,預計能使業者在技術研發和產品安全標準上有所根據。

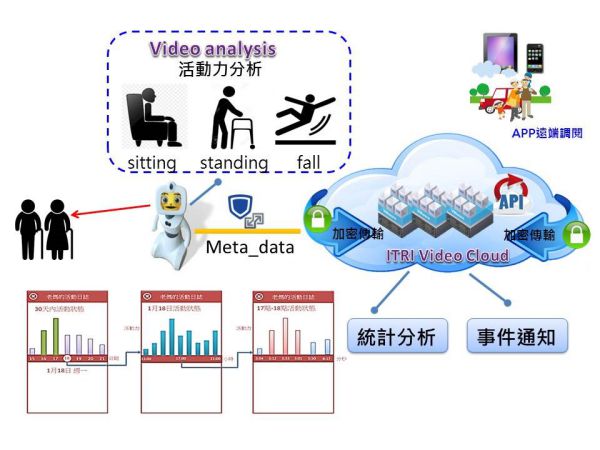

三、心情好:改良語音辨識技術觀察傾聽父母身心狀況,即時處理情緒反應

現今國際大廠如Apple Siri、Amazon Alexa、Google Assistant、Samsung Bixby等之語音辨識技術多集中在語音助理應用,且皆以大量整句文句語資料庫統計訓練的語言模型,所形成的辨識解碼框架,無法適用於真實情形下之人與人不打草稿的隨意談話訊號。配合長照政策工研院研發之語音相關技術有兩項特色,其一:全方位音訊分析技術,將打造仿真人與人交談的語音,且可有效處理其他音訊事件插入之狀況,以提供獨居長者身心狀態變化警訊;其二:進一步於全時聲音串流中,偵測長者特定的情緒示意關鍵詞,並於各種聲音事件中,找出長者所發出重要的口語段落並理解其語意內容。期望搭配這些語音及非語音的聲音分析內容來加強瞭解被照護者的身心變化狀況。 語音情緒偵測系統進行人聲分析與身心狀態理解系統框架實作,後續可提供關注者透過主動守護陪伴關懷服務來瞭解被關注者心理相關人聲事件,以及生理相關人聲事件;研發串流音訊處理模組,可持續接收串流音訊,設計可將聲音訊號進行分類、分段、標記與儲存的機制,並透過語音情緒偵測系統,可針對被關注者的語音訊號與非語音訊號來分析是否具有情緒的表徵。人聲分析與身心狀態理解系統示意圖如下所示:

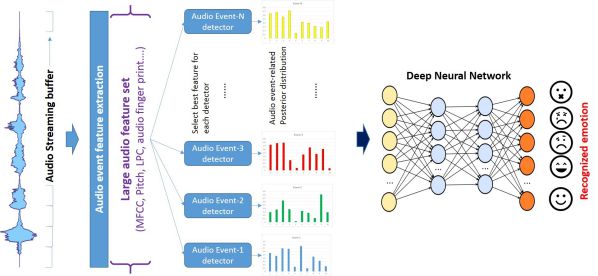

圖5 人聲分析與身心狀態理解系統示意圖

圖5 人聲分析與身心狀態理解系統示意圖過去音訊情緒辨識主要對語音部分進行各種特徵參數抽取,接者對一段語句內容進行情緒的識別。此方式依賴與使用者的交談內容,包括聲音及文字來進行判斷。本計畫預計利用偵測出的聲音事件搭配深度學習來訓練出各種音訊與目標情緒的對應關係,主要步驟如下:

- 開發聲音事件偵測器:研究設計各種情緒相關之聲音事件偵測器,蒐集目標聲音事件資料並找出有效的特徵。

- 深度學習語者情緒偵測:將整合後之各種聲音偵測的反應利用深度學習技術來連結與情緒之關係。

在串流式的聲音事件偵測情況下,我們將得到大量連續的偵測反應現象,而這些堆疊起來的複雜資訊內含被照護者的情緒反應。我們將利用深度類神經網路的特性來學習如何映射到各種不同的情緒,其技術概念圖如下:

圖6 基於聲音事件偵測之深度學習音訊情緒偵測技術

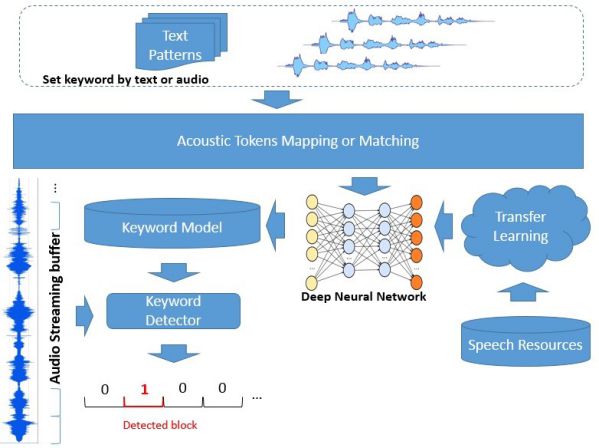

圖6 基於聲音事件偵測之深度學習音訊情緒偵測技術在包含語音的聲音事件中,許多夾帶的特定關鍵詞,包含感嘆詞甚至髒話與辱罵詞等等,這些都可在一定程度上反映語者的情緒現況。這些語音情緒示意詞的偵測辨識將能提供給照護者參考,瞭解被照護者的身心狀況。本計畫預計透過聲音或文字來指定該關鍵詞,透過「聲學意符」(Acoustic Token)辨識或轉換機制來建立關鍵詞偵測模型,以提供更通用、強健的比對基礎,如此更方便透過學習遷移(transfer learning)來補足原本因稀疏的訓練語料而造成的模型缺陷。以下是該技術示意圖:

圖7 語音情緒示意詞偵測技術

圖7 語音情緒示意詞偵測技術四、吃得好:居家飲食檢測系統觀察父母進食狀況,確認營養與食品安全

由於食用殘留有害物質或是腐壞食物,長期下來容易造成癌症及慢性病,利用非接觸式飲食檢測自動分析系統檢測食物腐敗,突破無法隨時觀測飲食的傳統方式。目前主要的關鍵技術缺口在於對於食材的檢測,皆是僅以食材圖片進行資料庫比對,並無法得知真實食材是否存在腐敗,且現有對於食物中有害物質的檢測偏向大型中央實驗室設備檢測,需專業人員操作,不僅需要長時間且缺乏智慧化、微型化,目前國內光譜檢測元件廠商具有硬體生產能力,唯智慧化能力以及系統化能力依然不足,難以整合具競爭力之系統,與國際大廠競爭。工研院研發居家飲食檢測及智慧化擴增資料庫系統,來建構完整的即時分析擴增之智能辨識應用服務,結合居家生活IoT應用,建立個人飲食管理服務,提升產品智慧化與廠商競爭力。 工研院以深度學習及即時影像辨識技術為基礎,建立居家飲食影像檢測分析系統,透過架設於居家中的影像擷取裝置或置入於機器人中的影像擷取裝置,取得每餐餐點的即時二維、三維影像,透過雲端處理架構,將影像即時上傳至雲端處理平台後,透過基於深度學習之影像分析技術,分析每餐菜色種類,並且透過食用前後的影像內容差異,分析相關飲食習慣資訊,如飲食時間、餐點剩餘等資訊。此外,採用雲端處理架構,可有效將資訊傳給相關醫療保健單位或營養師,進行達到居家飲食控管。

圖8 居家飲食影像檢測分析系統示意圖

圖8 居家飲食影像檢測分析系統示意圖

- 智慧影像食材種類辨識模型建立:收集大量料理圖庫,將料理食材種類分成三大類:蔬菜、魚、肉,透過深度學習之影像分析技術,建立影像食材種類辨識分析模型。

- 智慧飲食習慣分析模型建立:利用影像處理技術,分析每餐食用前與食用後的影像內容,以影像紋理特徵分析技術搭配機器學習演算法,判別每餐食用分量的差異,將食用殘餘量分為完食與殘食兩大類,並記錄用餐時間。

目前在居家照護上的應用主要以人物行為分析為主,為加速智慧照護技術實際應用至產業,本技術所開發之智慧影像食材種類辨識模型,採用雲端運算的處理架構,可提供給國內監控廠商技術應用整合,並且協助其建置多樣性的食材料理影像資料庫。以搭配工研院開發關鍵性之智慧影像食材種類辨識軟體,來協助國內業者由硬體跨足智慧化與產業升級。

建立階段性里程碑 持續產業化優化

在成果運用策略部分,以黃金世代及其父母為主軸,發展樂齡生活守護陪伴服務整體解決方案,同時整合線上、線下、第三方銀髮服務,與服務營運商合作提供服務,將結合前期人本感知與智慧生活整合服務計畫新創公司家幸福、社區物業、銀髮關懷據點等生態系夥伴,共同發展並提供獨居銀髮長者與其黃金世代子女(或照顧者)間O2O守護陪伴服務及商業合作模式。

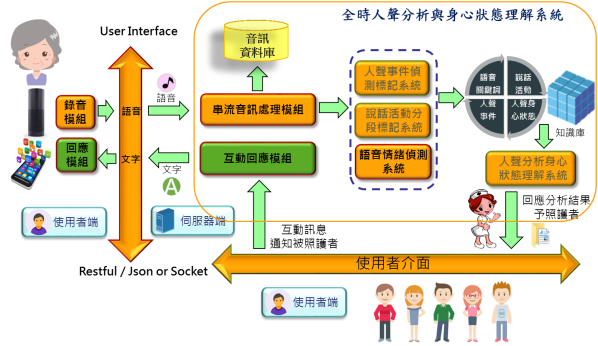

圖9 樂齡生活守護陪伴服務服務情境示意圖

圖9 樂齡生活守護陪伴服務服務情境示意圖銀髮長輩於家中透過新樂齡陪伴機(AMIBO)可與黃金世代子女手機或其他銀髮社群友人(使用AMIBO)無縫互動聯繫,子女亦可透過手機為遠端父母操作或設定新樂齡陪伴機之功能或訂購服務。新樂齡陪伴機於家中全天守候我們的父母,透過Ambient Intelligence環境智能技術能主動傾聽(audio)、觀察(video)與感知(sensor)父母生活日常及情緒,並提供智慧分析結果主動串連子女與友人,讓獨居父母擁有如子女親臨照顧的關心與生活支援。

新樂齡整體解決方案係基於「銀髮獨居長輩」及「黃金世代子女」等兩大目標族群需求所發展,經由四階段需求發展工作分析整理出各利害關係人需求痛點,包括:近半年次級資料收集分析;依長照高齡照護服務面向(機構/社區/居家)、政府(內政部、衛福部、社會局)評鑑優質照顧單位或據點名單,進行北、中、南區邀約訪談,共訪談11家機構或單位﹝長庚養生村、松柏園、悠然山莊、高雄仁愛之家、文山養護中心、永信長青學堂(日托)、永信日照中心、全愛全人關懷協會、中華民國老人福祉協會、台南林澄輝社會福利基金會、高雄市亞鐳慈善會﹞;深度專家訪談:拜訪國內長期投入高齡銀髮之意見領袖台北榮總高齡醫學中心陳亮恭主任及元智大學老人福祉研究中心徐業良教授,從長者生活照顧(如何不失能、不失智、不臥床,建立健康而無齡的熟年人生)到科技服務應用導入(排除長者孤獨、協助活化社會鏈結、將高科技無縫隱藏於具有溫度的服務,More Fun than Functions)經驗分享與討論;學研共創工作坊,分別與日本高齡服務及先進載具學術研究單位(山梨大學、未來大學),以及國內高齡應用服務研究單位合作(應用劇本實驗室),結合其生態系夥伴(弘道老人基金會)透過多次工作坊共創討論,挖掘價值主張、研擬服務設計與應用發展主軸。

掌握解決方案需求後,開始展開服務設計,包括:透過技術研究和競爭產品分析了解競爭優勢和限制、藉由使用者研究(例如觀察、訪談)來剖析使用者需求、透過技術盤點及工作坊形式展開服務情境設計、進行服務功能與流程設計、啟動新樂齡陪伴機使用者介面設計等。技術團隊依據需求發展與服務情境,展開系統架構設計與各項功能及系統規格訂定工作,以Ambient Intelligence為核心,整合全方位音訊分析技術、居家活動感知分析技術、居家飲食影像檢測分析系統等3項自主研發成果,建立國內第一套樂齡生活應用服務系統。

<strong>新樂齡應用服務系統發展,將以遠距智慧操控、身心智能感知、日記自動生成、第三方服務擴充等作為階段性里程碑,配合終端雛形發展及生態系推動、核心夥伴合作驗證、整體解決方案六都驗證等產業化推動工作,完成全程計畫目標。後續將展開各項技術及功能開發工作,並將反覆透過易用性測試以確認操作流程符合使用者經驗,同時透過具存取介面及共通平台設計,提供多元應用服務。規劃設計之功能與服務,將透過場域實證回饋,不斷進行動態調整與優化。</strong>

參考文獻

[1] https://telepresencerobots.com/

[2] Telepresence Robot Shipments to Total Nearly 100,000 Units by 2020

[3]https://www.tractica.com/newsroom/press-releases/telepresence-robot-shipments-to-total-nearly-100000-units-by-2020/

[4] S. Albawendi, et al., "Video Based Fall Detection with Enhanced Motion History Images," presented at the Proceedings of the 9th ACM International Conference on PErvasive Technologies Related to Assistive Environments, Corfu, Island, Greece, 2016.

[5] T. Sumiya, et al., "A Mobile Robot for Fall Detection for Elderly-Care," Procedia Computer Science, vol. 60, pp. 870-880, 2015/01/01/ 2015.

[6] Stuhlsatz, A., Meyer, C., Eyben, F., Zielke, T., Meier, G., Schuller, B., 2011. Deep neural networks for acoustic emotion recognition: raising the benchmarks. In: Proc. ICASSP, Prague, Czech Republic, pp. 5688–5691.

[7] K. Han, D. Yu, and I. Tashev. Speech Emotion Recognition using Deep Neural Network and Extreme Learning Machine. In Interspeech ’14.

相關連結: 回175期_智慧城市智能感知與物聯網專輯