工業技術研究院 資訊與通訊研究所 姚昌皜 劉柏凱 蔡依芸 林敬傑 林杰儒

全景畫面渲染技術與邊緣雲遠端渲染技術可提升頭戴式裝置畫質解析度,搭配多自由度移動全景畫面渲染技術強化沉浸體驗感,適合3D視訊會議、觀光推廣、專業訓練等應用領域。

前言

2023年WWDC蘋果發表首款頭戴式裝置(Head-Mounted Display, HMD)Vision Pro,裝置內部包含大量攝影機、感測器與麥克風,搭配自主研發的M2運算晶片與R1協同處理晶片,計算空間資訊與渲染高畫質畫面,確保使用者可以毫無延遲地看到外部實際的景象,提升混和實境(Mixed Reality, MR)的沉浸體驗感。而在今年初蘋果更進一步發表Apple Immersive Video應用,提供多部180度、8K解析度與空間音效的3D影片,帶領使用者穿梭時間與空間並感受猶如置身故事中心的沉浸體驗,被認為是現在Vision Pro上的殺手級應用。本文鎖定360度全景視訊給使用者帶來的擬真感與沉浸體驗,結合邊緣雲的高運算力與5G通訊的高可靠性,研發多自由度移動全景畫面渲染技術,解放只能在單一視角觀看影片的限制,讓使用者可以在全景視訊裡自由移動,提供其參與及深入故事發展的服務。

精彩內容

1. 元宇宙的關鍵頭戴式裝置

2. 殺手級應用的全景視訊製作

3. 提升頭戴式裝置渲染解析度

4. 多自由度全景視訊應用 |

元宇宙的關鍵—頭戴式裝置

頭戴式裝置的發展歷程

1935年科幻作家Stanley G. Weinbaum在小說中描繪了一款虛擬實境(Virtual Reality, VR)頭戴式裝置,使用者可以透過VR頭戴式裝置跟虛擬世界互動,甚至可以模擬視覺、嗅覺、觸覺與味覺等體驗,堪稱最早的頭戴式裝置概念,開啟頭戴式裝置研究的熱潮。1968年電腦圖形學之父Ivan Sutherland製作出世界上第一款具備頭部位置追蹤系統的頭戴式裝置,可依據使用者頭部旋轉位置於頭戴式裝置顯示器中呈現對應的視角畫面,但因裝置沉重只能懸吊於天花板。隨著半導體製程發展與製造技術工藝進步,感測器與圖形處理器在體積縮小的同時亦大幅推進運算效能的增長,2015年後迎來頭戴式裝置產品的推陳出新,Google、HTC、Oculus、Meta、Samsung、Sony、Microsoft等科技巨頭開始積極推出各自的頭戴式裝置。

2023年蘋果發表萬眾期待的第一款頭戴式裝置Vision Pro,讓元宇宙的話題徹底爆發,消費者可透過USB線材供給Vision Pro電力並持續使用約兩小時,但USB線材容易纏繞到手上,大大影響使用的靈活性;而Vision Pro有別於HTC前後平衡的配重設計,其重量主要集中於前面的顯示器區塊,導致消費者頭部和頸部容易感到疲勞;頭戴式裝置中進行大量的圖形處理運算所造成的過熱等上述問題,使得消費者購買意願下降。儘管蘋果於2024年4月已下修出貨量,但在MR應用體驗上,Vision Pro與手機相比仍然令人眼睛為之一亮,使得外界依舊看好頭戴式裝置的市場發展,並期待市場能出現輕便,但價格卻又更加親民的選擇。

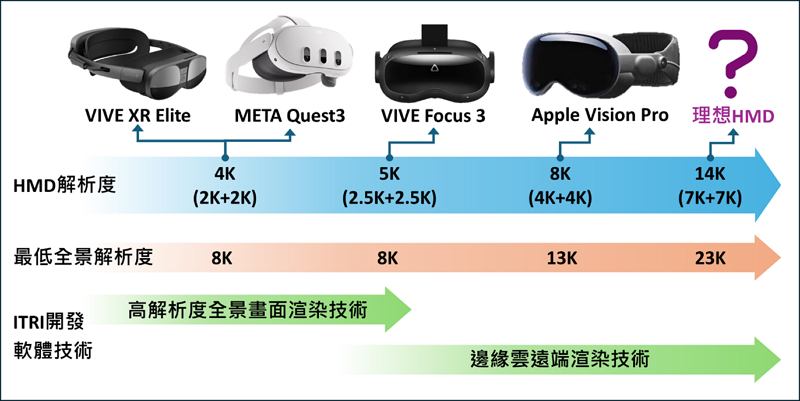

頭戴式裝置的關鍵技術

現階段頭戴式裝置的沉浸體驗著重於五感中的視覺與聽覺,其中視覺更是占了整體體驗的80%左右,影響頭戴式裝置視覺體驗的關鍵技術瓶頸在於顯示器的解析度大小與畫面更新率。依據人眼與顯示器的距離,計算出人眼最小可分辨的2點像素間距離,頭戴式裝置的單眼顯示器要滿足於一般人單隻眼睛可以看到的視野範圍(水平視角120度、垂直視角135度),至少需要7K的解析度。現今頭戴式裝置的規格如圖1所示,VIVE XR Elite [1]與META Quest3 [3]左右眼各自皆搭載單眼2K解析度的顯示器,VIVE Focus 3 [2]單眼的顯示器為2.5K解析度,而Vision Pro [4]配備現今頭戴式裝置最高規格單眼4K解析度的顯示器,因而台灣各家顯示面板廠商皆在發展高亮度與高像素密度的顯示器。為了讓使用者達到順暢且不暈眩的高品質沉浸體驗,顯示器的畫面更新率至少需達到90Hz到120Hz間,所以頭戴式裝置中需搭載強大的圖形處理器進行3D畫面渲染,META Quest3中搭載的高通Snapdragon XR2 Gen 2可支援4K 120Hz畫面更新率,蘋果Vision Pro自家研發的R1圖像運算處理器更可支援8K 100Hz畫面更新率,但如何在維持圖形處理器的運算能力下,解決散熱的問題將是未來的重點之一。

圖1 頭戴式裝置關鍵技術發展需求

殺手級應用的全景視訊製作

全景視訊內容的基本需求

蘋果於Vision Pro正式開賣前,發布被譽為Vision Pro現階段的殺手級應用Apple Immersive Video,提供多部高畫質VR180 3D視訊影片讓使用者觀賞,VR180為藉由兩支180度魚眼攝影機實際拍攝現實空間的VR視訊格式,兩支攝影機分別拍攝左右眼睛不同視角的視訊畫面,進而在頭戴式裝置上顯示出視差所產生的立體視覺,如圖2所示。而全景視訊VR360透過多支攝影機拍攝到的畫面組成一個可視角為360度的視訊規格,VR360相較於VR180視訊規格能提供全方位無死角的視野畫面,讓使用者可以第一人稱視角沉浸於影片的敘事情境中。根據頭戴式裝置的顯示器解析度與可視角,可計算出滿足頭戴式裝置顯示器所需的最低全景視訊解析度,如圖1所示,Vision Pro至少需要13K解析度的全景視訊才能提供使用者最佳的影像品質,如果是VR180視訊則至少需要6.5K解析度,Apple Immersive Video提供的8K VR180影片可為配戴Vision Pro的使用者帶來極為擬真的畫面呈現。

圖2 市售VR180與VR360攝影機

全景視訊攝影機的現況與應用情境

目前愈來愈多人使用消費級的全景視訊攝影機紀錄生活,也開始發展出監控、教育等非針對虛擬實境領域的應用,但市售的全景視訊攝影機皆無法滿足虛擬實境應用的基本需求。高端消費級全景視訊攝影機最高解析度雖達到8K,但畫面更新率僅有30Hz,而大多數全景視訊攝影機視訊規格還停留在4K解析度,無法滿足頭戴式裝置對於顯示器最低的全景視訊內容製作需求,甚至無法拍攝出符合頭戴式裝置左右眼顯示器解析度的立體VR360視訊內容,而VR360攝影機中負責處理多支攝影機的影像處理運算晶片與散熱設計是影響產品效能的關鍵問題。

提升頭戴式裝置渲染解析度

開啟3D通訊應用時代

隨著Vision Pro捨棄左右手把控制器,以直接使用手勢的使用者介面與互動方式獲得大眾的好評,並透過空間運算與虛實疊合渲染技術整合,將混合實境的應用推到一個新的層次,Vision Pro更展示出異地使用者在虛擬世界中視訊會議的應用情境,透過接收到的臉部特徵改變3D虛擬模型,帶來2D視訊通訊轉變到3D通訊的可能性,但要即時傳輸3D影像對於無線通訊網路的穩定性、抗干擾與傳輸速度都將是未來需要突破的問題。隨著頭戴式裝置日新月異的進展,圖形處理的能力迎來突破性的進步,但頭戴式裝置耗電快無法長時間使用、重量太重不適合長時間配戴等問題被消費者關注,後面章節將說明在現有的技術下如何提升全景視訊圖像處理效能的解決方案。

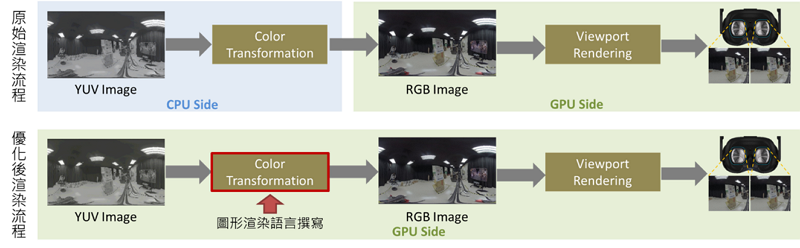

高解析度全景畫面渲染技術

頭戴式裝置渲染一張全景視訊畫面需先解碼出一張YUV格式的全景視訊畫面,然後將色彩空間轉換到RGB格式,最後依據使用者觀看視角與顯示器像素需求,由360度全景視訊畫面渲染出左右眼顯示器所需的顯示畫面,如圖3所示。本技術運用圖形渲染語言重新撰寫頭戴式裝置即時渲染功能與架構,優化渲染軟體於頭戴式裝置執行效能,使得渲染流程可以統一在GPU上處理,CPU與GPU間無須進行大量資料的記憶體搬遷處理,讓相同處理時間內頭戴式裝置可以渲染的全景視訊畫面解析度由2K提升到8K,滿足大部分頭戴式裝置配備顯示器所需最低全景視訊解析度的需求,如圖1所示。

圖3 頭戴式裝置渲染流程

邊緣雲遠端渲染技術

為了分散頭戴式裝置的運算負擔,透過無線通訊將頭部定位資訊傳輸到鄰近的邊緣雲伺服器,透過邊緣雲的高運算能力執行全景視訊畫面渲染運算,再將左右眼顯示器所需的畫面傳輸回頭戴式裝置上顯示,即為遠端渲染技術,使得頭戴式裝置無須計算360度全景視訊畫面所有的像素,只需針對使用者觀看的視角進行解碼與顯示,等同於頭戴式裝置可顯示8K解析度以上的全景視訊畫面,畫面更新率達到90Hz以上。

從頭部定位資訊傳出到渲染出畫面的延遲時間如果太長,將讓使用者的體感與視覺畫面不同步造成嚴重暈眩感,其中視訊編碼的延遲時間占整體端到端延遲時間的80%,為視訊傳輸系統中影響延遲時間的最重要因素。藉由解碼器端的延遲時間評估模型技術即時分析影響延遲時間變化的因子,再透過低延遲控制指標集與雙向控制信令技術將評估結果傳送到編碼器端,使編碼器可以即時調整動態畫面分割與自適應編碼率調整策略,讓視訊串流系統能夠在任一時間調整運作模式,降低網路環境不佳、解碼器處理時間增加等因素造成的延遲時間,首創以低延遲為目標做編碼率調整的視訊編碼系統,平均視訊編碼的延遲時間68ms,達到顯示的畫面隨著頭部移動即時改變,降低使用者的不適感。

多自由度全景視訊應用

多自由度移動全景畫面渲染技術

頭戴式裝置所渲染VR360全景視訊畫面通常都是在一個完整球形空間內以同一位置所觀看的自由視角畫面,雖與VR180相比使用者已可更加沉浸地體驗空間內容,但是多自由度移動全景畫面渲染技術可以渲染出兩個不同觀測位置的全景視訊畫面[5]-[7],增加使用者在全景視訊畫面裡的移動方向,提升全景視訊應用的自由度,支援使用者在場景中移動觀看的位置,達成在影片中隨意走動的應用情境。本技術首先會透過特徵點進行球面俯仰角轉換,將兩張不同視角畫面的觀看世界座標統一,再依據球面移動向量(motion vector)演算法,找出兩張不同全景視訊間景象與物件的移動向量,結合不同視角的位置與移動向量渲染出虛擬視角的全景視訊畫面。

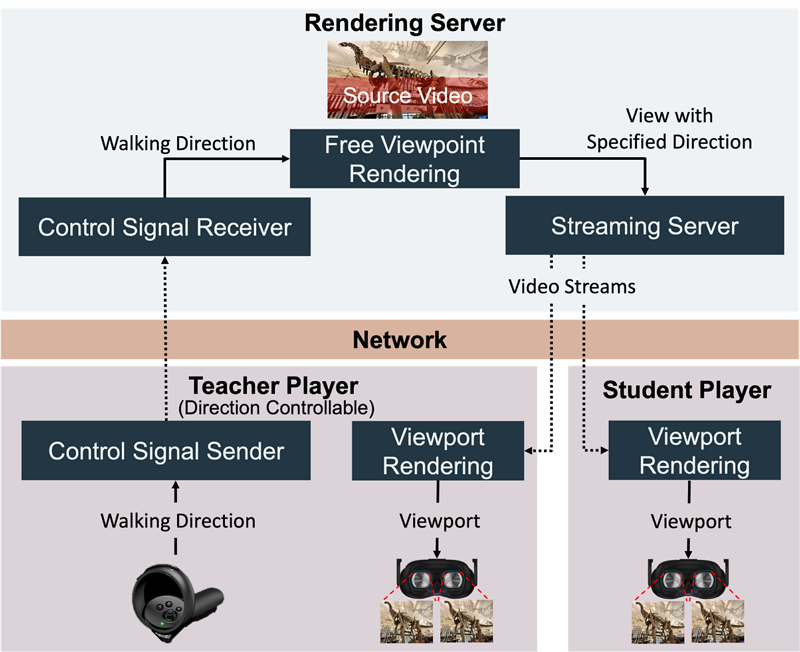

高擬真異地沉浸學習應用系統

本應用系統整合5G通訊網路、邊緣雲與虛擬實境技術,開發出應用於偏鄉教育領域的高擬真異地沉浸學習應用,通過沉浸式應用服務打破時空界限,使偏鄉學生不再因時間和距離等限制無法參觀博物館與美術館等藝文空間,減少偏鄉文化資源相較於城市匱乏的問題,降低城鄉教育資源落差,提高偏鄉學生多元學習機會。本系統架構如圖4所示,偏鄉老師透過手把控制器移動視角,並透過5G通訊網路將移動資訊傳輸至邊緣雲,應用邊緣雲高運算力與多自由度移動全景畫面渲染技術,渲染出虛擬視角的全景視訊畫面,再透過5G通訊網路同時將畫面傳輸至所有頭戴式裝置與教室電腦上,頭戴式裝置藉由高解析度全景畫面渲染技術顯示8K解析度的高畫質影像。

圖4 高擬真異地沉浸學習應用系統架構

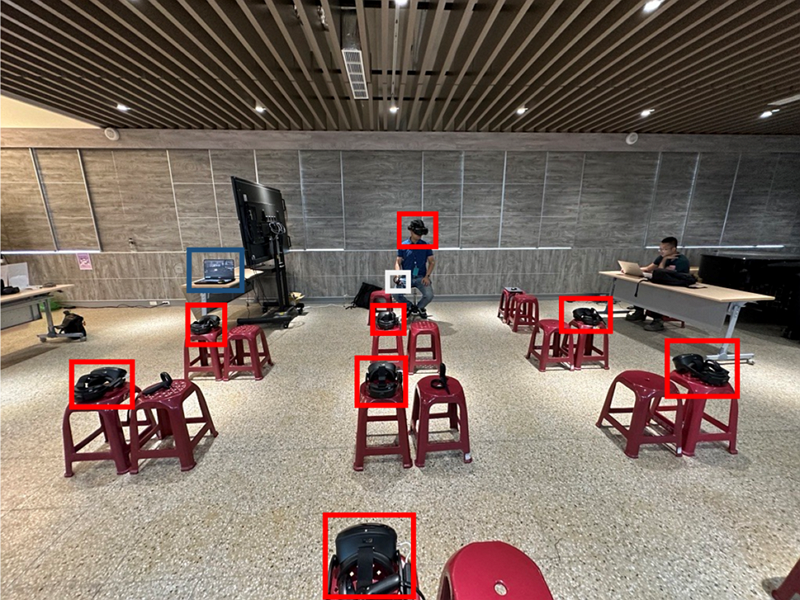

高擬真異地沉浸學習應用場域實績

本應用分別於兩間不同偏鄉小學場域部屬高擬真異地沉浸學習應用系統(如圖4),其中Network使用5G專網,讓超過50位學生實際體驗兩堂古今台灣系列課程,如圖5與圖6所示,場域內部署八台VR頭戴裝置(圖5中紅框)、一個自由視角移動控制器(圖5中白框)、一台教室電腦(圖5中籃框)與5G RU設備(圖6中白框),測試結果顯示平均自由視角全景畫面渲染速度達30.9FPS,綜合評估結果超過90%的學生對於課程內容安排覺得滿意。

圖5 高擬真異地沉浸學習應用場域部署圖

圖6 高擬真異地沉浸學習應用場域課堂活動圖

結論

隨著蘋果推出Vision Pro產品,元宇宙被視為智慧型手機後的劃時代產品,但也凸顯出現行的製造工藝與生態系問題,台灣在半導體、面板與伺服器製造領域皆有傑出的表現,具備在元宇宙領域發展關鍵技術的潛力。因此本文介紹應用高解析度全景畫面渲染技術與邊緣雲遠端渲染技術,提出在目前的硬體效能下提升顯示畫質的軟體解決方案,並研發多自由度移動全景畫面渲染技術,首創高擬真異地沉浸學習應用,未來更可拓展於專業訓練、觀光推廣、3D視訊會議等應用領域。

參考文獻

[1] VIVE XR Elite Tech Specs. [Online]. Available at: http://www.vive.com/tw/product/vive-xr-elite/specs/

[2] VIVE Focus 3 Tech Specs. [Online]. Available at: http://www.vive.com/tw/product/vive-focus3/specs/

[3] META Quest3 Tech Specs. [Online]. Available at: http://www.meta.com/tw/en/quest/quest-3/#specs

[4] Apple Vision Pro Tech Specs. [Online]. Available at:https://www.apple.com/apple-vision-pro/specs/

[5] Shuo-Han Yeh, “View Interpolation for Spherical Panorama,” M. Eng. thesis, National Tsing Hua University, Hsinchu, Taiwan, July, 2017.

[6] Naoki Kawai, Cédric Audras, Sou Tabata, and Takahiro Matsubara, “Panorama Image Interpolation for Real-time Walkthrough,“ SIGGRAPH Posters, 2016.

[7] Wenxin Zhang, Yumei Wang, and Yu Liu, “Generating High-Quality Panorama by View Synthesis Based on Optical Flow Estimation,” MDPI, 2022