工研院資通所 高榮揚 凃日昇

本文將以一個實際案例來說明360度全景視訊場內直播這個技術,此技術包含了低延遲最佳化的VR 360視訊縫合(stitch)、4K VR 360視訊壓縮、WiFi廣播通訊傳輸、網路串流與VR 360視訊播放等技術。借由這個案例說明技術細節與透過2017 WCIT會展展示此系統應用性,讓觀賞者可以透過此系統享受到場內低延遲感VR 360視訊,擁有第一排視角觀賞沉浸感。

系統架構

本系統開發了一個有別於以往的全景視訊(VR 360)直播系統,和傳統場外線上直播系統以服務非現場的觀眾不同,場外線上直播從攝影開始到把訊號傳輸給坐在家裡看電視的觀眾為止,這段延遲時間可能高達10秒至30秒,然而本場內直播應用,則將目標客群放在身處現場的觀眾上面,因此要解決的問題則鎖定在如何高度即時同步現場事件和VR畫面,讓VR所帶來的虛擬現實感,得以應用在場內直播服務上面,使得坐在後排使用者有如坐在VIP席位裡觀看比賽一般。

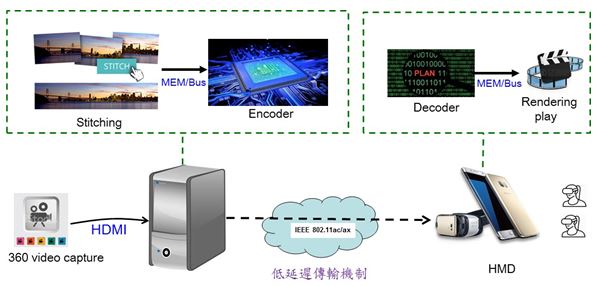

圖1 ITRI 場內VR360直播系統建置應用架構示意圖

圖1 ITRI 場內VR360直播系統建置應用架構示意圖整個360度全景視訊場內直播系統可以簡略地分為三個子系統,分別是內容來源端、網路傳輸機制和使用者端;第一個子系統是內容來源端系統,包含360度VR攝影機組、視訊縫合模組(stitching)和視訊編碼及串流模組(encoding & streaming)等(圖1),內容來源端負責拍攝360度全景視訊,並且再經由視訊縫合模組處理產生360度全景影像,最後再透過視訊編碼及串流模組來壓縮這個全景影片並發送到網路。而第二個子系統網路傳輸機制,則是負責把編碼壓縮完的360度全景視訊封包,從內容來源端傳送到使用者端。本系統使用獨家的WiFi群播/廣播的功能,可以在滿足高頻寬的傳輸需求之餘,還能同時服務多名使用者。第三個子系統是使用者端,使用者端在接收到了視訊封包之後,會再交由視訊解碼模組和顯示模組,進行視訊解碼和把解碼完的畫面顯示到頭戴式顯示器(Head-Mounted Display, HMD)上面,使用者就可以觀賞到360度全景的即時視訊了。

系統模組簡介

為了滿足現場高度即時同步的需求,本系統必須把從攝影機開始拍攝畫面然後一路到HMD顯示出畫面為止,這段過程的延遲時間壓縮到最短,而且由於使用者是在極近的距離下觀看HMD的畫面,所以在滿足觀賞體驗的前提下,高解析度與高畫面更新率的VR內容也將是必要的需求;綜合以上條件,本系統針對前一小節所提到的三項子系統,個別進行優化,提升整個系統的效能。

內容來源端

在內容來源端,開發低延遲全景視訊串流系統,以GPU加速處理技術強化視訊縫合模組的即時運算速度,提高畫面更新率,然後再搭配NVIDIA的nvenc編碼器,建構出我們的即時視訊縫合與編碼串流技術。

網路傳輸機制

在網路傳輸機制的部分,開發客制化設備使Wi-Fi具備群播/廣播能力,在降低延遲時間使用UDP傳輸的同時,依然具備相當程度的錯誤更正能力,並且支援用戶端無延遲緩衝器(cut-through buffer)給上層播放程式的功能。

使用者端

在使用者端,打造極低緩衝的客制化VR播放器,配合新一代的Qualcomm Snapdragon 835晶片,優化播放器軟體呼叫硬體解碼器的流程,採取預先初始化和移除多餘的緩衝這兩種手段,極力縮短整個顯示流程。

系統規格

此案例所開發之場內VR 360直播系統如上圖1所示,其包含以下3個模組:

1.360-degree Video Stitching Module

2.VR 360 Wi-Fi Multicasting/Broadcasting Module

3.VR 360 Player Module

360-degree Video Stitching Module

360-degree Video Stitching Module可執行於Windows作業系統平台,此軟體系統可接收多路攝影機訊號作為輸入源,並將這些攝影畫面進行視訊縫合(video stitch),產生出全景圖(panorama)串流,此全景圖串流將傳給本軟體系統所使用的視訊編碼器(video encoder)進行視訊編碼,然後發送到本場內直播系統的網路端設備。

技術項目支援的功能與輸出串流格式如下:

- 輸入訊號:輸入視訊串流支援多路攝影機透過HDMI訊號線,以特定之影像擷取卡連接接收後,傳送至搭載本軟體系統的server作為輸入訊號;來源攝影機的數量最高可達六支,解析度規格為1280x960,且固定焦距,此外,來源攝影機以每支攝影機面向不同的角度,並且令它們所涵蓋的視角範圍可以構成360度環繞畫面的方式,組成攝影機組(camera rig),另外,組成rig的這六支攝影機需盡可能地使它們的光心疊合在一起。

- 輸出訊號:輸出一路視訊串流,其視訊串流支援以下編碼標準與串流格式

支援 H.264 main / high profile

解析度:4K Ultra HD (3840x1920)

畫面更新率:每秒60幀(60 fps)

取樣色彩格式:YUV420P

VR360 Wi-Fi Multicasting/Broadcasting Module

支援發送端context aware FEC錯誤更正編碼能力

支援用戶端監控模式封包接收能力

支援用戶端監控模式封包過濾能力

支援用戶端context aware FEC錯誤更正解碼能力

支援用戶端無延遲緩衝器(cut-through buffer)給上層播放程式

VR 360 Player Module

功能項目及技術規格如下:接收協定:UDP-based protocol,並具備依據Video Timestamp及Packet Sequence重新排序封包功能

解碼模組(終端設備需有HW Decoder支援):支援H.264 Decoder 解析度:4K Ultra HD(3840x1920)

畫面更新率:每秒60幀(60 fps)

取樣色彩格式:YUV420P

實際場域驗證預計展示(2017 WCIT)

本案例預計將於2017年9月於台灣所舉辦的WCIT國際展上,進行實際場域展示,其預先規劃如下圖2所示,我們將以此展示來說明此案例的應用情形:

圖2 場內VR360直播系統展示情境圖

圖2 場內VR360直播系統展示情境圖展示情境與展示規劃:首先從現場透過360攝影機拉回訊號,現場分為會議廳與展示舞台兩類,透過系統,經由6鏡頭360度影像縫合、壓縮、streaming、無線傳輸、接收解碼、360 rendering等技術處理後,在明日未來區攤位的觀賞者將可即時看到異地場合演說或表演。並透過現場喇叭、麥克風跟會議、舞台現場進行即時互動,透過聲音與視訊的比較以展示系統之超低延遲性。另外同時於攤位放置雙螢幕,一邊顯示2D(由cable拉回2D一般視訊訊號,無延遲),另一邊則顯示由我們系統所送回之VR 360視訊(由system無線傳輸),兩邊可同時進行觀看比較,以驗證系統延遲性。

透過此一情境驗證,觀賞者即使位於表演後方或觀看死角,皆可透過此一系統,將表演內容即時傳送至後端觀賞者,讓觀賞者可以透過此系統享受到場內低延遲感VR 360視訊,並擁有第一排視角觀賞沉浸感;同時因人在活動表演現場,所以也將擁有現場氣氛同步感,達到身歷其境之真實與參與感。

傳統的場外線上直播,因觀賞者本人並不在現場,所以即使有10秒到30秒之間的延遲時間,也無法感覺有這些延遲。但本案例所應用的範圍為場內直播,指的是人在現場,但卻因位置偏遠或視角被遮蔽的緣故,無法清楚地觀賞現場表演內容,因此透過本系統可將前方視訊採用VR 360方式與低延遲方式回傳後排,讓後排觀眾可以第一時間體驗到第一視角。